修復Android手機無聲的問題 / Android Phone No Sound Problem Repair

修復Android手機無聲的問題 / Android Phone No Sound Problem Repair

當Android手機的電話無法從聽筒聽到聲音,卻可以用擴音聽到聲音時,很有可能是因為耳機偵測錯誤造成的問題。此時只要重新插入、拔出耳機,就能夠修復這個問題。

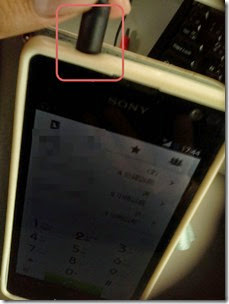

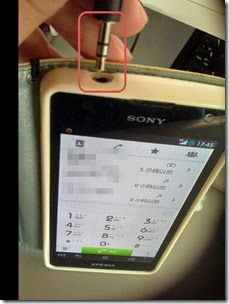

When you can not hear sound from your Android phone and you can use amplifier to play sound, it may be caused by the headphones incorrectly detected problem. To repair this problem, you can use a headphone to plug in and unplug.

聽筒無聲的問題 / No Sound Problem

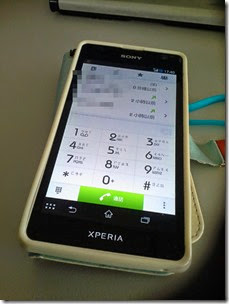

今天我接到電話時,我完全聽不到對方的聲音。幾經測試之後,發現我的Android 4.1 (Sony Xperia TX)手機不論是撥號還是接聽,對方的聲音完全是聽不見。我的聲音可以傳遞給對方,表示麥克風正常。若是按擴音,也可以聽到對方的聲音。我試著開機,但是問題仍舊相同。因此這可能也不是軟體的問題,而是內建聽筒的問題。

Android這種智慧型手機有個特色,就是能夠偵測耳機是否插入,決定聲音的輸出是要從內建聽筒、擴音器還是耳機輸出孔。雖然當時我並沒有插著耳機,但是我平時很常使用耳機聽音樂,這可能導致Android耳機偵測誤判了。

修復耳機偵測錯誤的問題 / Repair Headphones Incorrectly Detected Problem

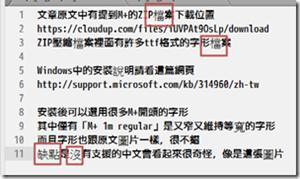

我使用以下的方法修復,做法很簡單。

這樣子再打電話就有聲音了。

我看網路上大家都是打到客服去問,結果受到的答案不是重開機就是回覆原廠設定,事實上只要找個耳機重新插入就能解決問題,請不要這麼大費周章喔。

(more...)

![image_thumb[1] image_thumb[1]](http://lh6.ggpht.com/-KY39x_RPLFs/U6KPJO4HeEI/AAAAAAABchI/OGLb2ZqaC3U/image_thumb%25255B1%25255D_thumb.png?imgmax=800)

Comments