Zentyal的DLLL-CIAS Router更新記錄 / DLLL-CIAS Router Moduel Update

Zentyal的DLLL-CIAS Router更新記錄 / DLLL-CIAS Router Moduel Update

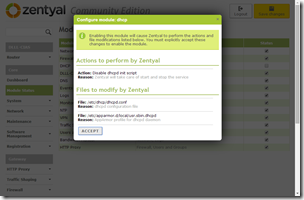

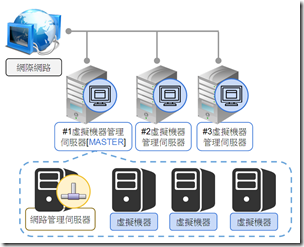

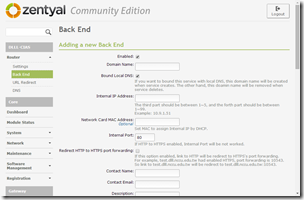

DLLL-CIAS Router是我在開放原始碼的網路路由器Zentyal上所開發的模組。這次我在Zentyal 4.1版本上再度開發了新版本的DLLL-CIAS Router。這個版本是特別為了DLLL-CIAS架構中的網路管理伺服器(Router)、資料儲存伺服器(Storage)、虛擬機器管理伺服器(Virtual Environment)、以及虛擬機器(Virtual Machines)的架構所設計,並且融入知識管理、允許重複網域名稱的功能,最後則是留下完整的安裝方法與自動備份的功能,即使Zentyal再度毀損也能夠輕易地將之還原。這篇記錄著這一版本DLLL-CIAS Router所增加的各種功能。

(more...)

Comments