我先從維基百科的虛擬機器比較表格中與KVM管理工具選擇伺服器虛擬化方案,再以免費、開放原始碼、客端電腦可運作的作業系統等條件篩選,然後再選擇活躍的、知名度較高的方案來安裝,並用用看各種功能。由於時間並不多,我主要關注安裝、管理、虛擬機器的建立與網路設定等部分功能,並沒有將每個方案的所有細節都摸透。詳細請看下面各方案的評比內容。

這一週多的時間內,我評比了7個方案,包括VirtualBox、Hyper-V Server 2008 R2、VMware ESXi、Citrix XenServer、OpenNode、Proxmox VE、Oracle VM,不過實際安裝到能夠成功使用的只有其中5個而已。以下一一介紹:

VirtualBox

簡介

Oracle VirtualBox是由德國InnoTek軟體公司出品的虛擬機器軟體,現在則由甲骨文公司進行開發,是甲骨文公司xVM虛擬化平臺技術的一部份。它提供使用者在32位元或64位元的Windows、Solaris及Linux 作業系統上虛擬其它x86的作業系統。使用者可以在VirtualBox上安裝並且執行Solaris、Windows、DOS、Linux、OS/2 Warp、OpenBSD及FreeBSD等作業系統作為客端電腦。

與同性質的VMware及Virtual PC比較下,VirtualBox獨到之處包括遠端桌面協定(RDP)、iSCSI及USB的支援,VirtualBox在客端電腦上已可以支援USB 2.0的硬體裝置,不過要安裝 virtualbox extension pack.。

VirtualBox跟Oracle VM Server的差異在於,前者是個人用的桌面虛擬化軟體,後者才是伺服器虛擬化的用途。因此跟以下我安裝的幾個伺服器虛擬化方案比起來,VirtualBox的功能有很大的差異。

豐富的網路設定

對我來說,我覺得VirtualBox最好用的地方在於網路設定:NAT模式。VirtualBox預設使用了NAT模式(Network Address Translation),客端電腦僅需要以DHCP設定網卡,就能從VirtualBox取得IP、連到網路,而幾乎所有客端電腦作業系統都預設採用這種方式連上網路。比起大多數虛擬機器都僅有提供橋接模式(Bridged Networking),安裝客端電腦時還需要特定配給IP、做額外的網路設定,擁有NAT模式的VirtualBox架設虛擬機器時就方便許多。

桌面虛擬化應用

此外,VirtualBox的3D加速與無接縫(seamless windows)功能相當實用,可以將模擬出來的虛擬機器當做Windows中的一個應用程式來使用。但是這個特色主要是用於個人的桌面虛擬化應用的目的,並不是伺服器虛擬化所關注的焦點。

即時遷移:Teleportation

VirtualBox在3.1版之後已經有即時遷移的功能,叫做「Teleportation」。與大多數提供即時遷移的虛擬機器一樣,都需要一個共享儲存環境作為暫存的角色。但是在使用即時遷移的時候,多伺服器整合的監控管理介面是很重要的工具,而Teleportation目前卻仍是以指令列操縱為主,也沒有高可用的相關技術可以一起搭配使用,因此實用度有待評估。

phpVirtualBox簡介

VirtualBox提供了本機端的圖形化管理介面,但也僅有供本機端使用。儘管我們可以用遠端桌面、VNC等遠端操控伺服器的工具來管理,但仍有所不便。為了遠端管理VirtualBox,phpVirtualBox提供了一套管理系統,並成為VirtualBox專案中相當火熱的焦點議題。

如果要用大量管理虛擬化伺服器的角度來評比VirtualBox,那麼應該要連phpVirtualBox也一併介紹才行。

|  |

| VirtualBox管理介面 | phpVirtualBox管理介面 |

phpVirtualBox幾乎把VirtualBox圖形化管理介面都模擬出來了,還加上了遠端管理時需要有的權限控管功能:除了帳號密碼設定之外,還能規範哪個IP的電腦才能連到phpVirtualBox進行管理,這點相當貼心。

phpVirtualBox的限制

phpVirtualBox必須搭配apache與PHP執行環境才能運作,此外也要一併開啟VirtualBox的VBoxWebSrv功能。安裝phpVirtualBox前置作業較為繁雜,而必須額外開啟VBoxWebSrv才能順利連線,這又是為自動運作為目標的伺服器加上了額外的麻煩。

phpVirtualBox支援多台VirtualBox伺服器的整合管理。例如我有三台設有VirtualBox的伺服器,那麼我可以在phpVirtualBox的設定中將這三台伺服器列入管理設定,登入時就能夠一併管理。

但是由於phpVirtualBox需要對應VirtualBox的版本才能正常運作,如果我們要管理的伺服器各別安裝了不同版本的VirtualBox,例如一台是3.x版本、另一台是4.1.0版本,那麼就不能用一個phpVirtualBox來整合管理這些伺服器了。不過這只要規劃時有所考量,就不會是什麼問題。

VirtualBox安裝過程

Windows中安裝

我在Windows 7作業系統中安裝VirtualBox,然後再把phpVirtualBox配置到Apache中。配置phpVirtualBox的時候遇到了些問題,像是phpVirtualBox版本跟VirtualBox不合、不小心用管理者模式開啟VBoxWebSrv.exe等自己操作的錯誤,都不是什麼大問題。搞定後就可以開啟phpVirtualBox來管理VirtualBox了。

phpVirtualBox太慢了

但是phpVirtualBox的開啟速度可說是出乎意料的慢。我自認為我現在用的四核心電腦並不差,而且目前也沒有執行太多需要吃資源的軟體。但即使如此,從登入phpVirtualBox到看到操作畫面,至少讓我等了個5分鐘左右吧。而裡面要做任何的動作,也都要等相當久才有反應。

此外,虛擬機器主控台的功能也無法順利開啟,真不知道是我哪裡架設錯誤了,十分讓人灰心。

然而光是緩慢的問題,就足以讓人決定捨棄VirtualBox與phpVirtualBox的組合方案了。

Hyper-V Server 2008 R2

Microsoft Hyper-V Server 2008 是一項獨立的產品,提供了空機安裝的方式,達到簡易、可靠、符合成本效益且最佳化的虛擬化解決方案,協助公司提升伺服器的使用率並降低成本。

它可將工作負載整合至單一實體伺服器;提供適用於開發與測試環境的基本簡易虛擬化解決方案;支援現有的 IT 基礎結構,協助公司降低成本、提升使用率,及佈署新的伺服器;充分利用現有的修補 / 佈署 / 管理與支援工具 / 程序。

Windows的管理介面

在官方介紹中看不太出來Hyper-V跟其他產品有啥差別。最大的決定性差異,應該就是管理介面使用了大家熟悉的Windows 2008。你可以用熟悉的方式進入Windows、設定防火牆等工作。這對已經習慣Linux的我來說,這並不是什麼特別的優勢,但對未來的管理者來說應該還是一件好事。

相較於大多數虛擬化技術對於Windows支援較差,XenServer等方案在沒有VT-x / AMD-V的加持之下甚至是不能以全虛擬化安裝Windows,Hyper-V絕對是Windows作業系統使用者的不二選擇。

Windows授權

Hyper-V的另一個優勢,就是虛擬機器中客端主機的Windows授權是包含在Hyper-V當中的。以VMware為例,安裝Windows的客端主機時,每一個客端主機理論上都需要獨立的授權(例如序號之類的)。但是一台Hyper-V企業版伺服器,就包含了四台客端主機的Windows授權。可以想像成買一份Windows又送你四份Windows的感覺。

詳細的授權細節我並不是很瞭解,因為實驗室這邊的Windows基本上都是使用學校的大量授權,因此並不需要特別在意授權數量上的限制。

Linux支援不足

不過相對的,Hyper-V在Linux作業系統支援就顯得薄弱:它只能安裝SUSE企業版伺服器、Red Hat Linux。常用的Debian卻不在名單上。

本篇主要需要架設的伺服器中,Linux佔了相當大的比重,因此這成為我並沒有選用Hyper-V的主要原因。

VMware ESXi

VMware的伺服器虛擬化方案為VMware vShpere,這是一個綜合多種元件與軟體的綜合性大型方案,提供虛擬機器、集中管理、虛擬網卡與虛擬儲存裝置、即時遷移與高可用等功能。

免費的VMware ESXi

VMware大部分元件都是要收費的,只有最底層的元件:伺服器虛擬化主端電腦VMware ESXi(以下簡稱為ESXi)可供免費下載、安裝。你只要輸入可免費取得的序號,就能夠延長ESXi的使用期限。

ESXi是以空機安裝的方式配置,你可以從VMware網站上下載ISO光碟來安裝。安裝完之後ESXi有著經過設計的文字介面主控台,可以快速設定伺服器的網路、密碼等。ESXi本身是個精簡型的Linux,許多Linux常見的套件都沒有安裝,因此較難對ESXi動手腳,也確保ESXi運作的穩定性。

VMware vShpere Client

虛擬機器的管理上則是以獨立的管理軟體VMware vShpere Client(以下簡稱vShpere Client)進行。供人免費使用的vShpere Client一次只能連線到一台ESXi主機,它可以調整ESXi伺服器的設定、檔案傳送(上傳ISO或虛擬裝置)、虛擬機器的監控、記錄與控制,也可以開啟虛擬機器主控台。

虛擬機器的新增與設定都與以往常見的VMware Workstation很像,在全虛擬化技術的支持下,你可以控制虛擬機器的大部分硬體設定,就像是組一台電腦一樣。

不過ESXi的網路模式跟Workstation有很大的差別,它只有提供虛擬交換器(vSwitch)跟VMkernel。後者是用來配置ESXi相關服務,像是vMotion(類似即時遷移等)。ESXi沒有NAT伺服器,所以沒辦法自動分配IP給客端電腦,這點必須自己想辦法。

豐富的資源

VMware系列產品在虛擬化技術中廣為人知,相關的資源與應用也非常多。VMware上提供了1799種虛擬裝置可以馬上下載來使用。我之前研究的DSpace也有提供VMware的虛擬裝置。

此外,VMware提供的免費工具VMware vCenter Converter Standalone也具備了相當高相容性的P2V、V2V功能。P2V是指實體機器轉換成虛擬機器,而V2V則是虛擬機器轉換成另一種虛擬機器。你甚至可以將Norton Ghost、Acronis True Image的硬碟映像檔轉換成VMware的虛擬機器。

VMware ESXi安裝過程

安裝過程十分順利

我使用了ESXi 4.1版進行空機安裝。因為在VirtualBox上怎樣進了安裝畫面,所以我是用實體機器來安裝ESXi。

安裝過程只有硬碟分割、密碼等少數設定需要輸入,大部分都由系統自行去判斷。大概不到五分鐘就安裝完畢了,令人訝異的輕快。

然後是下載vShpere Client並連線到ESXi管理,ESXi也支援全虛擬化,所以也可以安裝Windows。但是它的網路設定有點複雜,直到現在我也只能理解vSwitch的運作而已。

簡單安裝幾個虛擬機器之後很快就上手了,網路上也有很多圖文並茂的心得文,例如挨踢人的VMware vSphere 4安裝試用與不專業網管筆記的VMware ESXi實戰全記錄,再此就不再額外記錄。

手動建立NAT內部網路

至於NAT的問題,我參考RomanT.net的Configuring NAT on ESX and ESXi一文,在ESXi中架設一個pfSense伺服器以提供DHCP、NAT的功能,而其他虛擬機器則透過pfSense來進行連線。這種方式會讓ESXi跟pfSense都各別佔據一個IP,還不算是理想的解決方案。但這種方案不管是用在ESXi還是XenServer等類似的虛擬內部網路架構中都能夠適用。

VMware GO無法使用

vShpere Client只能管理一台伺服器,而另一個管理方案VMware GO則是可以管理多台ESXi。它是架設在VMware網站上的網站服務,而不是我們可以自行安裝、架設的伺服器,所以必須連到VMware進行操作。

然而,我在VMware GO新增ESXi的動作卻一直都沒有成功過,不知道是哪裡設定錯誤。網路上看得到的VMware GO文章好多都是官方的廣告說明,例如伺服器虛擬化管理服務─VMware GO,但內容都大同小異。實際上用VMware GO的人好像不多的感覺,不知道是不是我的錯覺?

Citrix XenServer

簡介

Citrix XenServer 是一種全面而易於管理的伺服器虛擬化平臺,建構於強大 Xen Hypervisor 程式之上。Xen 技術被廣泛視為業界最快速、最安全虛擬化軟體。XenServer 是為了高效率管理 Windows® 和 Linux® 虛擬伺服器所設計,可提供符合成本效益的伺服器整合和業務連續性。

XenServer有著與VMware vShpere、Hyper-V 2008 Server R2等類似的功能,但是XenServer在免費版就能使用很多其他廠商方案中需要付費才能使用的功能,像是即時遷移、高可用等伺服器虛擬化所需要的技術。

XenServer是基於知名的開放原始碼虛擬機器技術:Xen。許多Linux發行版中就能預先安裝Xen,鳥哥也有介紹如何在Linux中使用Xen。Citrix XenServer也是利用Xen的虛擬電腦技術,製作出整合型的管理方案。

網路心得豐富

儘管市面上電腦圖書不常看到XenServer的介紹,但是網路上研究XenServer的文章卻還蠻容易找到的。

射手科技採用XenServer作為他們的虛擬化應用方案,對於為何採用XenServer的理由以及使用XenServer時遇到的瑣事做了詳細的記錄,是官方說明之外的另一種角度的使用者說明。

一個低調而不張揚的角落跟黃小瀞的學習筆記也有介紹XenServer的安裝過程,圖文並茂相當詳細,我在安裝XenServer的許多障礙都可以從這邊找到解答。

Citrix XenServer安裝過程

可以安裝在VirtualBox中

VirtualBox的設定細節

XenServer必須安裝在64位元的電腦中。剛好我的VirtualBox可以模擬64位元的電腦,所以我就用VirtualBox來安裝XenServer,並直接讓AP配給它IP。

空機安裝

XenServer是採空機安裝的方式,安裝過程沒什麼問題。安裝好之後很快就能看到XenServer的主控台。接著先用瀏覽器連線到XenServer,它會提示你下載XenCenter安裝檔,好用來管理XenServer。

Citrix XenCenter

在此使用的是Windows環境中使用的版本。安裝過程也十分簡單,請看黃小瀞的學習筆記的說明即可。

半虛擬化的限制

在安裝虛擬機器時遇到了一些麻煩。由於VirtualBox無法提供VT-x / AMD-V給XenServer,所以XenServer只能用半虛擬化(Paravirtualization)模式建立虛擬機器。

XenServer半虛擬化支援的樣板,但是Windows在安裝過程中必須全虛擬化進行

半虛擬化技術最為人詬病的地方,就是必須使用特定的作業系統,並修改該作業系統的核心,這樣才能順利運作。XenServer提供了許多Linux發佈版跟Windows的樣板,不過Windows在安裝過程中需要全虛擬化,所以我連新增都不能新增。Linux發佈版中也限定了版本,我下載了許多CentOS,到最後還是用CentOS 5才能順利運作。直到安裝XenTool之後,整個新增虛擬機器的工程才算是完成。

網路上可以找到供XenServer使用的樣板,像是Ubuntu 9.10,可是我下載之後卻無法使用,令人感到灰心。

網路設定

網路的部份,XenServer也只有提供橋接模式與內部網路模式。如果要用NAT模式的話,可以參考三块石头的Citrix XenServer上实现NAT介紹。其作法是建立虛擬路由器、虛擬網卡,然後用iptables來做NAT連接埠的轉遞。這樣還沒有DHCP服務,所以必須手動分配虛擬機器的IP。雖然這都是Linux網路的基礎技巧,但是由於操作還是太過繁雜,所以我並不打算這樣做。

另一個作法是像ESXi一樣建立pfSense路由器,不過也會有多佔據一個IP的缺點就是。

小結

XenServer有著不輸給VMware ESXi的伺服器虛擬化方案,免費版就能使用許多功能,令人感到興奮。但是因為我的伺服器沒有VT-x / AMD-V技術,新增虛擬機器的過程中老是綁手綁腳,令人難以適應。最後還是放棄不使用XenServer了。

OpenNode

OpenNode雲端平台(OpenNode Clode Platform)是一個開放原始碼伺服器虛擬化與管理方案,它包括了以下幾個元件:

虛擬化技術

OpenNode採用了KVM的全虛擬化與半虛擬化技術,同時也用了OpenVZ的容器虛擬化技術。這種虛擬化技術組合在開放原始碼專案中似乎很常見,Proxmox也是採用了類似的方案。

空機安裝

基於CentOS的空機安裝ISO檔,支援OpenVZ容器虛擬化與新興的KVM全虛擬化技術。OpenNode的命令列管理也使用了OpenNode CLI Utility與廣為人知的virsh與vzctl技術。

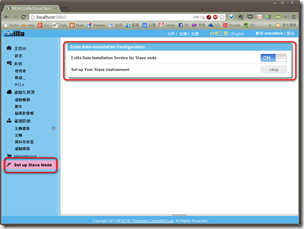

OpenNode Management Server(簡稱OMS)

OMS是以虛擬裝置打包(OpenVZ的半虛擬化技術),可以輕易安裝到OpenNode伺服器中整合運作。

管理主控台

OpenNode管理主控台,在這邊通常稱為管理介面,稱之為「FuncMAN」。它是次世代網頁式AJAX管理主控台,具備非常簡單與整齊的版面設計。在OpenNode伺服器的虛擬機器實體管理上,採用了以HTML5為基礎的VNC與SSH虛擬機器主控台。OpenNode管理主控台是含括在管理伺服器中。

整合不如Proxmox

基本上,OpenNode採用的技術與Proxmox很像。虛擬機器可設定的部分都一樣,網路設定也只有虛擬內部網路、橋接模式,沒有NAT。但整體來說,Proxmox的整合程度比起OpenNode高很多,以下敘述我安裝與使用的過程。

OpenNode安裝過程

有如CentOS的空機安裝

十分精美的安裝介面

OpenNode伺服器的安裝很簡單,就跟安裝CentOS一樣……因為他本來就是基於CentOS去修改的。安裝畫面很漂亮,但是安裝所需時間卻也跟CentOS一樣長,跟VMware ESXi比起來就差很多。

安裝OMS與連線配置

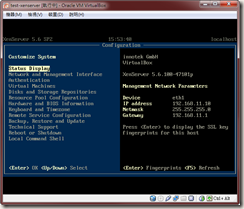

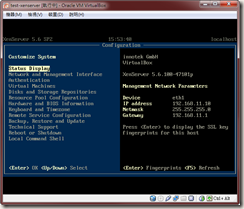

OpenNode的文字介面主控台

安裝完OpenNode伺服器之後,接下來要在OpenNode伺服器的主控台中安裝OpenNode Management Server(簡稱OMS)。安裝時是下載OpenVZ的虛擬裝置打包檔,將OMS建立成伺服器中的虛擬機器。因此你還需要給OMS額外的IP,讓他能夠連到網路供人連線,這是我覺得很麻煩的缺點。

OMS必須要以完整的FQDN(Fully qualified domain name,就是完整的網域名稱啦)來解析、連線。舉例來說,OMS的IP如果是192.168.56.101,那麼我必須給他一個FQDN,例如「opennode.dlll.nccu.edu.tw」,這樣才能連線,這似乎是SSL安全認證的需求。

FQDN的設定通常要搭配DNS伺服器來指定,不過也可以修改要客戶端的網域解析hots檔案,讓客戶端手動辨識FQDN、連到對應的OMS的IP上。Windows請修改C:\Windows\System32\drivers\etc\hosts;Linux通常是修改/etc/hosts,詳情請參考鳥哥的教學。

OMS匯入OpenNode伺服器

連線到OMS時需要輸入帳號密碼,帳號是root,密碼則是剛剛建立OMS時設定的資料。然後OMS會要你安裝安全憑證,以SSL方式跟OpenNode連線,提高安全性。

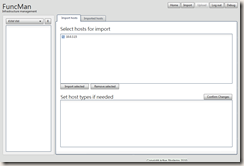

OMS剛安裝完的時候看不到任何主機,我們必須手動匯入OpenNode伺服器。

OMS剛安裝完的時候看不到任何主機,我們必須手動匯入OpenNode伺服器。

使用手冊上講述兩種方法,我是用OpenNode文字主控台登入,然後再到OMS中選擇要匯入的主機。

匯入的過程要等待很久,我想應該有10分鐘左右吧,而OMS卻不會有任何運作提示。一開始我一直以為是我輸入錯誤了,等很久之後,才看到OpenNode伺服器成功匯入OMS。

成功匯入一台OpenNode伺服器之後,OMS就時常需要讀取伺服器的資料,而且讀取速度非常慢,操作並不太順暢。儘管如此,還是比phpVirtualBox還要快就是了。

成功匯入一台OpenNode伺服器之後,OMS就時常需要讀取伺服器的資料,而且讀取速度非常慢,操作並不太順暢。儘管如此,還是比phpVirtualBox還要快就是了。

從樣板建立虛擬機器

由於這台OpenNode沒有VT-x / AMD-V技術,虛擬化的部分只能使用OpenVZ的容器虛擬化,因此必須要下載虛擬裝置才能建立新的虛擬機器。

OpenNode下載虛擬裝置的操作是在伺服器主控台中,可以選擇的虛擬裝置都是乾淨各個Linux發佈版,這似乎是OpenVZ預設的虛擬裝置。相較之下,Proxmox有些虛擬裝置會預先安裝好服務,較為實用。而Proxmox在網頁端就執行下載虛擬裝置的動作,整合度更勝OpenNode。

OpenNode下載虛擬裝置的操作是在伺服器主控台中,可以選擇的虛擬裝置都是乾淨各個Linux發佈版,這似乎是OpenVZ預設的虛擬裝置。相較之下,Proxmox有些虛擬裝置會預先安裝好服務,較為實用。而Proxmox在網頁端就執行下載虛擬裝置的動作,整合度更勝OpenNode。

下載好虛擬裝置之後,就能夠在OMS建立虛擬機器。建立的方式與Proxmox雷同,畢竟都是使用同樣的OpenVZ技術。建立時需要花點時間,但是OMS卻像是沒有回應一樣的呆滯住,操作起來實在是不怎麼流暢,強調AJAX技術卻沒有帶來相對應的優勢啊。

虛擬機器的主控台稱之為「WebShell」,是以HTML5技術寫成的,頗為特別。但老實說不太好用,不如Proxmox的Java Applet還容易上手。

虛擬機器的主控台稱之為「WebShell」,是以HTML5技術寫成的,頗為特別。但老實說不太好用,不如Proxmox的Java Applet還容易上手。

小結

稍微操作了一下,感覺上,要用OpenNode不如用Proxmox吧。

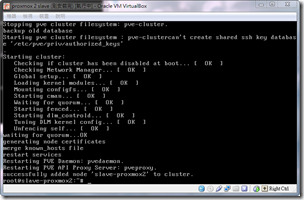

Proxmox VE

簡介

「在一小時裡面建立完整的虛擬伺服器平台」。這個Proxmox的願景可不是痴人說夢話,而是一個可行性相當高的方案──而且還是免費的開放原始碼專案!

Proxmox使用了KVM的全虛擬化與半虛擬化技術,以及OpenVZ的容器虛擬化技術(只能供Linux的客端電腦使用)。然而KVM需要有Intel VT-x / AMD-V技術支援,我目前只能測試OpenVZ的容器虛擬化。

虛擬裝置應用

真的只要一個小時,你不僅可以將一台空的伺服器安裝成Proxmox,然後快速地建立起郵件伺服器(Proxmox Mail Gateway)、內容管理平台(Joomla)等各種常見的虛擬裝置。一個可以馬上使用的網站系統就這樣完成了!

操作門檻低

Proxmox不僅是快,而且是個高度整合的方案,換句話說,他用起來非常簡單!習慣用VirtualBox或是更複雜的VMware的我,在一開始就為它過於簡單的操作方式而感到困惑。但經過短時間的摸索、閱讀安裝文件、熟悉Proxmox的使用方式之後,現在則是對它高度整合的成果感到十分敬佩!

接著我就介紹一下Proxmox的安裝、使用過程吧!

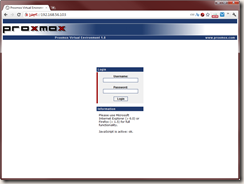

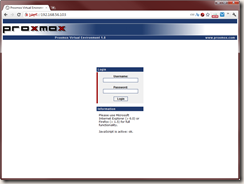

Proxmox VE安裝過程

空機安裝

Proxmox提供了空機安裝的方式,讓你快速建立起基於Debian的虛擬機器伺服器,內含用瀏覽器就能連線的網頁管理平台,一應俱全。

網頁管理平台的帳號密碼是與Proxmox的Linux系統結合在一起,因此你不需要設定太多套帳號,這是高度整合的具體表現。

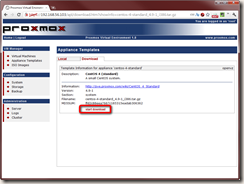

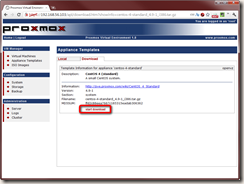

從虛擬裝置建立虛擬機器

由於我只能用容器虛擬化技術,所以我必須從虛擬裝置來建立虛擬機器。Proxmox最特別的地方,就是它準備了一堆的虛擬裝置(Virtual Appliance)──就是將已經安裝好、配置好的作業系統,上面甚至會安裝好特定的應用工具,然後包在一起供人下載取用。

虛擬裝置可以從Proxmox的網站下載,不過Proxmox的管理介面就內建下載清單了。

虛擬裝置可以從Proxmox的網站下載,不過Proxmox的管理介面就內建下載清單了。

你可以從管理介面直接將虛擬裝置下載到Proxmox VE伺服器中,操作起來一氣呵成、不需要多餘的步驟。

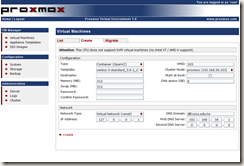

下載完之後就能在建立虛擬機器中選擇該虛擬裝置作為範本,同時可以為他設定基本常用的參數,包括root的密碼。大概只要兩分鐘,一台全新可用的虛擬機器就建好了。

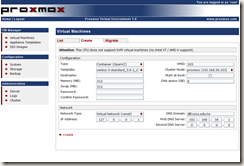

虛擬機器設定

建立虛擬機器的部份,跟其他虛擬機器平台比起來,特別是超複雜的VMware ESXi或是比較像個人電腦的VirtualBox來說,Proxmox建立虛擬機器中可以自訂的設定非常少,一開始使用時讓我有點不知道該如何下手。

不過重要的設定該有的還是都有,像是硬碟容量、記憶體、網路。我後來才知道,大部分Open VZ的虛擬機器都是如此。其中網路設定的部份,他也只有橋接模式,只是Network Type要選Virtual Network (venet),用橋接網卡反而無法運作,奇怪。

以Java Applet實作虛擬機器主控台

在主控台操作方面,Proxmox是以Java Applet元件,利用VNC來連線。操控上出乎意料地簡單,按鍵也不會被捕捉鎖定(例如VMware預設要用ctrl + alt來解除捕捉鎖定),感覺就像是在用PieTTY操控主控台一樣的容易。不過,可惜複製貼上這種動作還是做不到的啦。

在主控台操作方面,Proxmox是以Java Applet元件,利用VNC來連線。操控上出乎意料地簡單,按鍵也不會被捕捉鎖定(例如VMware預設要用ctrl + alt來解除捕捉鎖定),感覺就像是在用PieTTY操控主控台一樣的容易。不過,可惜複製貼上這種動作還是做不到的啦。

小結

Proxmox的設定太過簡單了,似乎沒辦法像VMware一樣弄出複雜的網路結構。不過換個角度想,簡單也是一件好事,正符合本篇所需要的容易管理優點。我很中意這個方案。

OracleVM

- 專案網站:Oracle VM Overview

- 維基百科:Oracle VM

- 下載網頁(Oracle VM要先註冊登入才能下載,註冊是免費的。)

- 使用版本:Oracle VM 2.2.2 Media Pack(內含OracleVM-Server-2.2.2.iso與OracleVM-Manager-2.2.0.iso)

簡介

Oracle VM為甲骨文公司(Oracle)所發行的企業級開放原始碼虛擬機監視器,其建基於Xen。其免費供應於大眾下載、使用與發布,並為使用者提供有償支援。

Server與Manager

Oracle VM分成Server跟Manager兩個元件,它都是提供ISO檔供人免費下載。其中Server是空機安裝,Manager則是要依附作業系統來安裝。

Manager硬體要求條件最少2GB記憶體、4GB的硬碟空間,因此可能難以裝在預設的虛擬機器中,這是需要注意的地方。

網路

Oracle VM的網路似乎只有提供橋接模式,因此它在文件中建議我們在Oracle VM前面設置好DHCP伺服器,再來進行虛擬機器的安裝。

樣板

Oracle VM提供了樣板安裝,這是已經安裝好了作業系統,只要下載、放到Oracle VM中,就能夠直接使用。

Oracle VM安裝過程

實體機器安裝

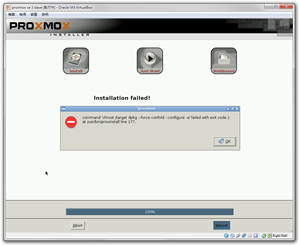

由於我在VirtualBox跟VMware ESXi中都無法順利進入Oracle VM Server的安裝畫面,所以我把它燒成光碟後,放到實體機器上安裝。

實體機器上的安裝過程十分順利,很快就架設好Oracle VM Server。然後我才想起來還要安裝Oracle VM Manager。

安裝Oracle VM Manager

本來我想把Oracle VM Manager裝在Orcale VM Server的電腦上,但是它的安裝器不知道是哪裡搞錯了,跟我講說硬碟空間不足,明明安裝完Oracle VM Server之後還有18x GB的空間。

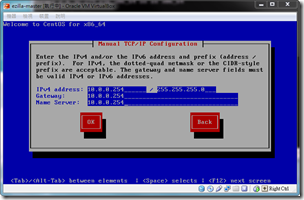

因此我只好另外架設虛擬機器,先安裝CentOS 5作業系統,再來安裝Oracle VM Manager。

Oracle VM Manager安裝過程照文件進行操作即可,大致上沒什麼問題。在安裝過程中會安裝許多工具,而它會一一要你設定密碼,這點十分煩人。

無法連線到Manager

Manager安裝完之後,應該可以透過「http[s]://IP_address:port/OVS」連接到Oracle VM Manager的管理介面。

儘管看起來各元件都正常啟動了,防火牆也開啟所需要的連接埠,但我卻怎樣都連線不了,一直看到「錯誤 102 (net::ERR_CONNECTION_REFUSED): 伺服器拒絕連線。」的問題。

我嘗試以上步驟安裝了第二次,還是一樣無法使用Orcale VM Manager。因此許多功能都還沒嘗試使用,Oracle VM就被我放棄了。

(more...)

Comments