ownCloud安裝檔案移動(files_mv)應用程式 / ownCloud Install Files Move (files_mv) App

ownCloud安裝檔案移動(files_mv)應用程式 / ownCloud Install Files Move (files_mv) App

ownCloud是一個類似Dropbox的雲端硬碟開放原始碼服務軟體,以PHP搭配MySQL架設,特別適用於Linux環境。ownCloud 6.0的網頁使用介面並沒有提供檔案搬移的功能,但是可以透過安裝Files Move (files_mv)應用程式,讓使用者可以在網頁使用介面中直接搬移檔案。

ownCloud is an opensource software which provide a cloud storage service like Dropbox. In ownCloud 6.0, user cannot move files in web interface. But you can install Files Move (files_mv) app to provide this function.

STEP.1 下載flies_mv外掛 / Download files_mv App

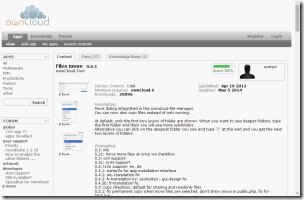

- 應用程式網頁:ownCloud應用程式 Files move

- 下載連接:http://apps.owncloud.com/content/download.php?content=150271&id=1&tan=3

4483315 - 布丁的備份檔案:Files move 0.6.3備份

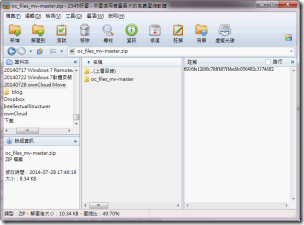

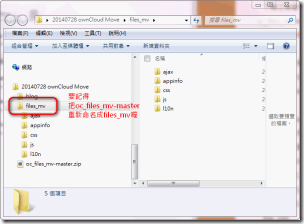

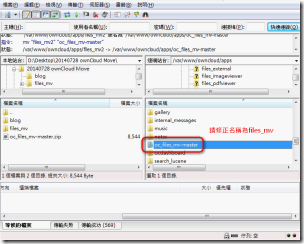

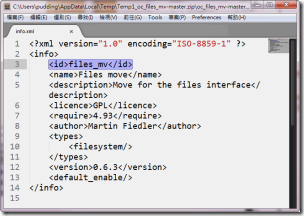

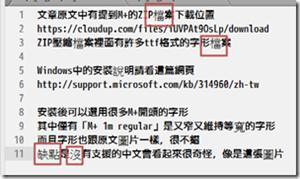

下載之後會得到一個zip壓縮檔,解壓縮後獲得一個資料夾名為「oc_files_mv-master」,底下有ajax、appinfo等5個資料夾。

接著請重新命名該資料夾為「files_mv」,以免遇到無法啟用應用程式的問題。

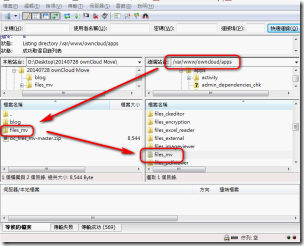

STEP.2 上傳files_mv檔案 / Upload files_mv Files

請上傳到你ownCloud安裝資料夾底下的apps資料夾。

如果你的ownCloud安裝在 /var/www/owncloud 底下,那麼上傳路徑就是 /var/www/owncloud/apps/底下。

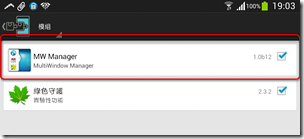

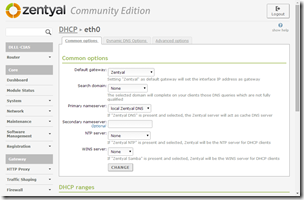

STEP.3 啟用files_mv / Enable files_mv App

[Oc登入畫面]

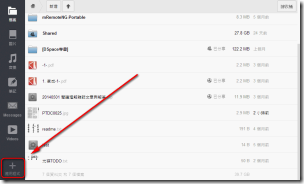

接著請開啟ownCloud的網頁使用介面,並以管理員(Administrator)群組中的身份登入OwnCloud。

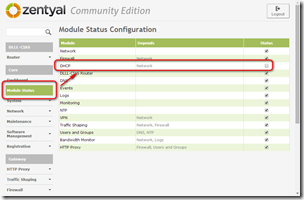

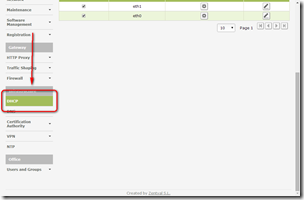

到左下角進入應用程式管理介面。

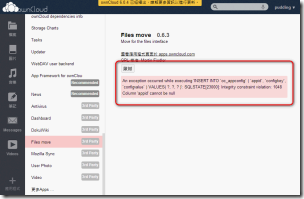

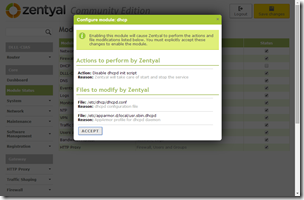

找到Files Move,進入Files Move設定畫面,按下啟用(Enable)按鈕。

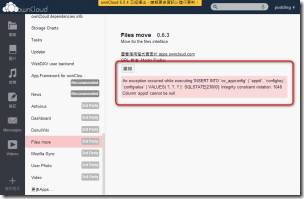

如果出現以下錯誤訊息:

「An exception occurred while executing 'INSERT INTO `oc_appconfig` ( `appid`, `configkey`, `configvalue` ) VALUES( ?, ?, ? )': SQLSTATE[23000]: Integrity constraint violation: 1048 Column 'appid' cannot be null」

表示你的資料夾名字未正確命名為「files_mv」,請仔細檢查。詳細請看我另一篇的介紹。

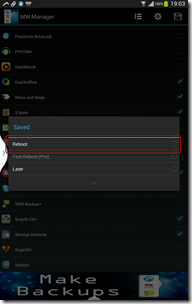

完成安裝

啟用完成之後,Files move會移動到上方,跟其他已經啟用的應用程式放在一起。

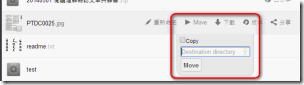

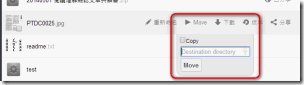

回到檔案列表,你就可以看到檔案右邊功能多出一個「Move」按鈕。點下去之後,就可以指定要移動的路徑,可以手動輸入路徑,或是從下拉選單中所列出的目錄選取。最後再按下「Move」按鈕就可以開始移動。

如果檔案很大的話,移動會花上比較長的時間。它不會提示移動進度,請耐心等候。

儘管Files Move (files_mv) 並不若一般Windows檔案管理介面那樣好操作,但總比無法搬移檔案的好,免費的軟體就加減用吧!

(more...)

![2014-07-28_192006_thumb[1] 2014-07-28_192006_thumb[1]](http://lh6.ggpht.com/-zmXp2nmkuM4/U9Y7ct7puvI/AAAAAAABgSc/sZ0VzyQATxE/2014-07-28_192006_thumb%25255B1%25255D_thumb.png?imgmax=800)

![2014-07-28_193312_thumb[2] 2014-07-28_193312_thumb[2]](http://lh3.ggpht.com/-4B0KA-Hdq1I/U9Y7jBq0b1I/AAAAAAABgS8/45G5vAEkR_k/2014-07-28_193312_thumb%25255B2%25255D_thumb.png?imgmax=800)

![20140723 [BLOG] Multi Window Manager - 6 20140723 [BLOG] Multi Window Manager - 6](http://lh5.ggpht.com/-GGkt1OSqaxM/U8-_q1TyRrI/AAAAAAABfDE/NI5NQrzwssk/20140723%252520%25255BBLOG%25255D%252520Multi%252520Window%252520Manager%252520-%2525206_thumb%25255B2%25255D.png?imgmax=800)

![20140723 [BLOG] Multi Window Manager - 4 annotated 20140723 [BLOG] Multi Window Manager - 4 annotated](http://lh4.ggpht.com/-IRu_ql8K-4c/U8-_zSGHQrI/AAAAAAABfD0/NFfkZPi-fTk/20140723%252520%25255BBLOG%25255D%252520Multi%252520Window%252520Manager%252520-%2525204%252520annotated_thumb.png?imgmax=800)

![20140723 [BLOG] Multi Window Manager - 2- Annotated 20140723 [BLOG] Multi Window Manager - 2- Annotated](http://lh6.ggpht.com/-BDj10d0ITdg/U8-_9OQqUfI/AAAAAAABfEk/roBx37A9kDI/20140723%252520%25255BBLOG%25255D%252520Multi%252520Window%252520Manager%252520-%2525202-%252520Annotated_thumb.png?imgmax=800)

![20140723 [BLOG] Multi Window Manager - 7 20140723 [BLOG] Multi Window Manager - 7](http://lh3.ggpht.com/-yskzUwpnx2M/U8_APx0wMCI/AAAAAAABfFo/PA-1zAMyP4A/20140723%252520%25255BBLOG%25255D%252520Multi%252520Window%252520Manager%252520-%2525207_thumb.png?imgmax=800)

Comments