用Weka找出最特別的文本:局部異數因素之異常偵測 / Mining the Special Text with Weka: Local Outlier Factors (LOF) for Anomaly Detection

我們要如何在大量文本當中,快速找出談論內容與眾不同、別有見地的文本呢?字數長短可能會被灌水,從字詞內容著手,也許是個合理的開始。本篇將應用資料探勘中異常偵測(anomaly detection)常見的演算法:局部異數因素(Local Outlier Factor, LOF),在Weka中找出用詞最為與眾不同的文本。

單變項的離群值偵測 / Detection of outliers in univariate

(圖片來源:用R畫箱型圖)

統計上的異常值偵測大多是處理單一變項。處理方法有兩種:

- 無母數法:以四分位距來決定籬笆,超越籬笆的數值則為離群值。詳細作法請參考用R畫箱型圖這篇。

- 有母數法:基於資料為常態分佈的假設,將落於樣本平均數正負三個樣本標準差外的數值視為離群值。具體做法是計算標準分數(z-score),大於3以上就是出現機率為0.13%以下的離群值。

關於這兩種作法,可以參考離群值的檢測的這篇。然而上述這兩種方法只能適用於單一維度的變項上,不能直接套用在多維度的資料中。而多維度資料的處理,則是資料探勘擅長的領域。

多變項的異常偵測:局部異數因素 / Anomal detection in multivariate: Local Outlier Factor

在多維度的資料中,我們得要先將多維變項降維,使之成為資料案例(instance)與案例之間的距離。在文本探勘的概念中,也就是「A文件跟B文件用詞的相似程度」,如果「A文件」與「B文件」所使用的詞彙大量重複,則兩文件之間的距離很近;反之,若「A文件」和「B文件」的用詞都不相同,則兩文件之間的距離很遠。

在計算出各個案例之間的距離之後,我們就可以來計算每一份案例的異常程度,也就是局部異數因素(Local Outlier Factor),以下將之簡稱為LOF。LOF是Markus M. Breunig、Hans-Peter Kriegel、Raymond T. Ng與Jörg Sander 在2000年提出的演算法,它是用密度的概念來判斷案例的異常程度。

我們以上圖來簡單說明LOF的概念。在這個例子中的四個案例裡,右邊三個案例彼此之間距離都很近,而左邊的案例距離它們就遠了許多。對任一藍色案例來說,它們到紅色案例的距離,比到其他藍色案例的距離都還要遠。則紅色案例則被這些藍色案例當作是「異數」(outliter)。而被作為異數的程度則是以一個數值來表示,也就是LOF。

每筆案例所計算出的LOF數值,在不同範圍裡有不同意義:

- 如果LOF接近1,表示該案例週遭的密度跟它的鄰居們週遭的密度接近。

- 如果LOF小於1,則表示該案例週遭的密度比它鄰居們週遭的密度還要高,也就是內圍值(inlier)。

- 如果LOF大於1,則表示該案例週遭的密度比它鄰居們週遭的密度還要低,也就是離群值(outlier)。

關於詳細的計算方式可以看看維基百科:Local outlier factor。在計算上是有點複雜,不過還好Weka的套件中有提供局部異數因素的演算法,套件名為「localOutlierFactor」。

開放原始碼的資料探勘工具:Weka / Weka: an open source data mining tool

(圖片來源:Weka鳥的動圖)

Weka是紐西蘭懷卡托大學機器學習實驗室(Machine Learning Group at the University of Waikato)發展的資料探勘工具,以GUN授權發佈,是資料探勘領域中重要的自由軟體。雖然跟現在的Python、R相比,Weka的演算法只有少數經典的資料探勘演算法,其中一個經典演算法就是本篇要講的局部異數因素LOF。

安裝套件:局部異數因素 / Install package: localOutlierFactor

Weka預設的演算法中並沒有安裝本文所需要的LOF,不過你可以透過Weka提供的「Package Manager」(套件管理器)來安裝額外的套件。LOF的名稱為「localOutlierFactor」,請參考「Weka下載與套件安裝教學」這篇的作法來安裝套件吧。

此外,使用Weka做中文的文本探勘,還需要注意以下兩點:

這些以前都介紹過了,這次就不再贅述囉。讓我們進入操作吧!

操作步驟 / Tutorial outline

整體來說本此操作有四大步驟:

- 文件資料集:下載練習用的資料來源。

- 資料前處理之斷詞:使用線上中文斷詞工具Jieba-JS來進行斷詞處理。

- Weka的LOF操作:使用Weka計算LOF分數。

- 解讀不同LOF分數的結果:將LOF分數放回原始資料集中,觀察LOF最高和最低的文件有何不同。

STEP 1. 文件資料集 / Dataset: Abstracts of medical papers collection

這份資料集是我從臺灣博碩士論文加值系統中取出30篇醫學相關論文的摘要彙集而成。這些摘要內容少則三百多字、多則一千七百多字。我們能從裡面找出跟別的論文最不同、最特別的摘要嗎?以下就讓我們用這份資料集作為例子,看看如何使用Weka的LOF吧。

1-1. 建立副本 / Make a copy

需要重新截圖,把token欄位刪掉

由於text-mining-lof這份資料是作為示範使用,我沒有開放編輯權限。如果你想要練習的話,直接點選上面「建立副本」的連結,Google雲端硬碟會直接將該檔案複製到你的雲端硬碟中,請用你複製的副本來練習吧。

STEP 2. 資料前處理之斷詞 / Preprocess: Tokenization

(圖片來源:非結構化資料分析:文本分類)

Weka在計算文件與文件的相似距離上,使用的是「字詞」為單位。如果兩份文件使用了相同的「字詞」,則兩份文件的距離比較近;反之,如果兩份文件使用的「字詞」大多都不相同,則兩份文件的距離比較遠。

我們必須要先把一連長串的中文摘要進行斷詞處理,在詞與詞之間加入空格,使得Weka能夠認得那些中文字才算是一個字詞。你可以手動加入空格來進行斷詞處理,也可以使用我開發的線上中文斷詞工具Jieba-JS,請結巴演算法自動進行斷詞。

2-1. 中文線上斷詞工具:Jieba-JS / Online Chinese Tokenization Tool: Jieba-JS

- 開啟新視窗: Jieba-JS

- 開啟彈跳視窗: Jieba-JS

- Jieba-JS的介紹:線上中文斷詞工具:Jieba-JS

- GitHub專案:jieba-js

接下來就讓我們來看看要怎麼用Jieba-JS做斷詞處理。

2-2. 斷詞處理 / Tokenization process

首先,我們要複製「abstract」(摘要)這一欄。請先選取「abstract」30篇摘要的文字,然後按「Ctrl+C」複製。

在Jieba-JS當中,將剛剛複製的文字貼到「Raw Text」裡面。

移除Word Remap、User Dictionary,然後在Stop Words下面按下「example」,載入常用的停用字。

- Word Remap表示對應詞典,例如我們要將「台灣」對應成「臺灣」,以確保Weka會將這兩個詞視為相同的詞彙。

- User Dictionary表示使用者詞典,例如我們不想要讓「台」跟「灣」被斷開成兩個字,希望確保「台灣」是一個詞。則我們可以設定「台灣,9999999,n」。

- Stop Words表示停用字詞典,Jieba-JS會移除停用字詞典裡面出現的字詞,確保斷詞處理後不會出現我們不想要看到的文字。

關於這三個選項的設定,請參考我在發掘文件中的主題:Weka分群應用於文本探勘中對於設定斷詞規則的說明。

設定完成後就按下「開始斷詞」。

右上角的「Processed Text」就會出現斷詞結果。我們可以按右上角的複製按鈕來複製斷詞結果。

我們回到剛剛的試算表裡面,按下面的名為「tokenization」的另一個工作表(sheet)來保存斷詞結果。

貼上斷詞結果。

接著我們要把這個工作表下載成CSV格式。請按「File」 > 「Download as」 > 「Comma-separated values (.csv, current sheet)」。

如果你不想做上面的步驟就看到這裡的話,你也可以下載我準備好的檔案:

記好你存放檔案的位置,待會我們就要用Weka來開啟它囉。

STEP 3. Weka的LOF操作 / Calculate LOF in Weka

開啓Weka之後,一開始會出現上圖的選單。我們要選擇其中的「Explorer」,開啓初學者專用的探索器。

3-1. 讀取CSV檔案 / Load CSV

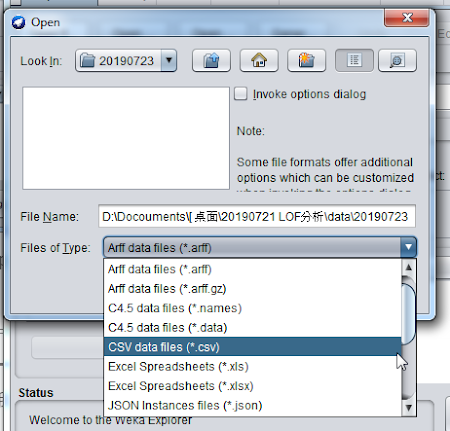

開啟Weka Explorer之後,先按下左上角的「Open file...」(開啟檔案)按鈕。

因為我們要開啟CSV檔案,請在Files of Type (檔案類型)要選擇「CSV data files (*.csv)」(CSV資料檔案(*.csv))。

這樣就可以看到我們剛剛儲存的CSV檔案。選擇它並按下「Open」按鈕。

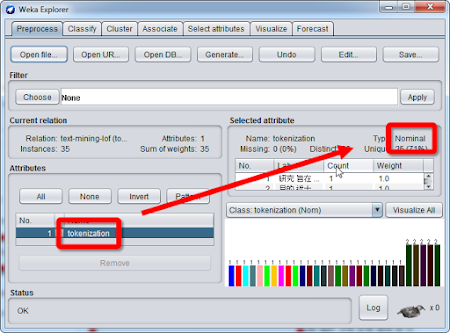

CSV檔案順利讀取。Weka會將CSV檔案每一個直欄視為一種屬性(attribute),而每個直欄的第一個橫列就是屬性的名稱。因為我們的工作表只有一個直欄,而直欄的第一個橫列就名為「tokenization」,所以這邊Weka載入CSV之後,就只有一個屬性,名為「tokenization」。

好的,讓我們進入下一步。

3-2. 類別轉換成字串 / Nominal to string

剛載入的CSV檔案會把文字資料的欄位視為「Nominal」(類別,或是名義變項)。我們需要把它轉換成「String」(字串)資料類型之後,才能進行後續的文本探勘。我們可以用Filter (過濾器)將「Nominal」轉換成「String」。

點選「Filter」(過濾器)底下的「Choose」(選擇)按鈕。

依序進入「weka」 >「filters」 > 「unsupervised」 > 「attribute」 > 「NominalToString」,這個過濾器就是將類別轉換成字串的工具。

然後按下「Apply」按鈕。

tokenization屬性的資料類型就成為「String」(字串)了。

3-3. 從字串建立文字向量模型 / String to word vector

再來我們要將字串轉換成「文字向量模型」(word vector model)中的「詞袋模型」(bag-of-words model)。此作法依然是用Filter (過濾器),不過是用StringToWordVector工具。

請按下「Filter」(過濾器)底下的「Choose」(選擇),然後依序選擇「weka」 >「filters」 > 「unsupervised」 > 「attribute」 > 「StringToWordVector」,這個過濾器就是將字串轉換成文字向量模型的工具。

接著我們還要設定「StringToWordVector」過濾器工具。請在粗體字的「StringToWordVector」上面按滑鼠左鍵。

這邊我們要設定的是最下面的「wordToKeep」選項,請將之設為「1000000」,讓Weka保留足夠多的字詞吧。關於StringToWordVector的設定,請參考我在發掘文件中的主題:Weka分群應用於文本探勘中對於不同的文字向量模型:詞袋、詞頻到TF-IDF的說明。

設定完成後就按下「OK」。

按下「Apply」按鈕,套用篩選器的設定。

我們可以看到屬性數量從原本只有一個tokenization,變成了2013個屬性。每個屬性代表著每份文件是否有包含屬性名稱的字詞。以「高風險」這個屬性名稱來說,如果該論文摘要有包含「高風險」這個詞,則在「高風險」屬性中的值就是「1」。如果該論文摘要沒有包含「高風險」這個詞,則在「高風險」屬性中的值就是「0」。

將字串轉換成文字向量模型之後,我們就可以來計算LOF了。

3-4. 計算局部異數因素 / Calculate Local Outlier Factor

在Weka中,LOF的計算也是透過Filter篩選器進行。

請按下「Filter」(過濾器)底下的「Choose」(選擇),然後依序選擇「weka」 >「filters」 > 「unsupervised」 > 「attribute」 > 「LOF」,這個過濾器就是計算局部異數因素LOF的工具。

如果你沒有在列表中發現LOF,那可能是你還沒安裝LOF套件。請參考前面的說明來安裝「localOutlierFactor」套件。

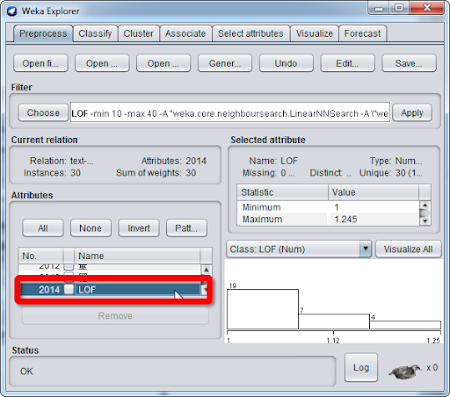

按下「Apply」套用LOF過濾器。

計算LOF需要花費一些時間,請稍候片刻。計算完成後,Weka會將LOF的計算結果記錄在最後一個屬性「LOF」中。我們可以看到該屬性最小值(Minimum)是「1」,最大值(Maximum)是「1.245」。

3-5. 取得LOF計算結果 / Save LOF result

再來我們要取得LOF的結果。但是在這之前,我們得要刪除LOF之外的其他欄位。

按下「Attributes」底下的「All」,此時所有屬性會被勾選起來。

將「LOF」屬性取消打勾。

按下「Remove」按鈕。

最後就會只剩下「LOF」一個欄位。

按右上角的「Save...」儲存檔案。

將「File of Type」(檔案類型)設為「CSV files: comma separated files (*.csv)」(CSV資料檔案(*.csv))。移動到你要儲存的位置,設定好「File Name」(檔案名稱),就可以按下「Save」儲存。

讓我們用試算表工具來開啟這個CSV檔案。個人推薦使用LibreOffice Calc。

開啟CSV,裡面就只有一個直欄,就是LOF。

讓我們選取並複製LOF欄位的資料。

回到Google試算表,切回「data」工作表,把LOF的結果貼在LOF的欄位。這樣我們就可以知道每個摘要對應的LOF分數。

再來我們要來將LOF由大到小排序。先把輸入位置放在LOF的欄位上,然後按下「Data」(資料)中的「Sort sheet by column C, Z → A」(依C欄排序工作表(Z → A))。

我們可以看到摘要已經按照LOF數值,由大到小排序了。

STEP 4. 分析結果:高LOF和低LOW的摘要之間的差異 / Result: The difference between abstracts with high LOF and low LOF

- 摘要的LOF分析結果:Google試算表、 CSV、 OpenDocument Spreadsheet、 Microsoft Excel

如果你直接跳到這個步驟,想要看看結果如何,你可以下載上面的摘要LO分析算結果連結來看看。

在分析結果中,每筆摘要都有一個局部異數因素(Local Outlier Factor, LOF)。LOF在不同範圍裡有不同意義:

- 如果LOF接近1,表示該摘要週遭的密度跟它的鄰居們週遭的密度接近。也就是該摘要所使用的字詞,類似於其他的摘要。

- 如果LOF小於1,則表示該摘要週遭的密度比它鄰居們週遭的密度還要高,也就是內圍值(inlier)。

- 如果LOF大於1,則表示該摘要的密度比它鄰居們週遭的密度還要低,也就是離群值(outlier)。換句話說,該摘要所使用的字詞,跟其他摘要使用的字詞有很大的不同。這就是我們要找的特別文本。

在本此分析中,LOF最高為1.245387,最低為1.000391。接下來就讓我們拿出LOF最高的前兩名摘要,以及LOF最低的前兩名摘要,看看他們之間的異同吧。

4-1. LOW最高的兩份摘要 / The abstracts with highest and second highest LOF

LOF第一高的摘要為1.245387分,這表示它使用的字詞明顯與其他摘要不同。該摘要共有1792個字,讓我們來看看該摘要寫了什麼:

本研究旨在以經驗學習理論的應用,探討台灣與香港長期照顧機構管理者增能歷程,以及比較兩地管理者增能歷程之異同,進而建構台港兩地機構管理者增能模式。茲就具體研究目的分別為:一、比較台港兩地管理者擔任管理職位的背景與動機;二、比較台港兩地管理者目前工作內容及其所需具備之核心能力;三、比較台港兩地管理者初任管理職、當前主要困境與未來困境,以及因應困境的策略、增能方式及增能結果;四、建構台港兩地長期照顧機構管理者增能模式;五、根據研究結論,提出未來對台港兩地長期照顧機構與政府培育人才,以及未來相關研究之參考。 本研究採用質性研究法,並以半結構式訪談法蒐集資料,進而採用比較研究法,以進行歸納和比較台灣與香港長期照顧機構管理者增能歷程之異同。本研究共訪談16 間台港兩地長期照顧機構管理者。其中,台灣機構管理者共十位,有五間是經政府評鑑為優等的機構,五間是甲等機構,包含四位男性、六位女性,其在目前機構的服務年資為2~18年,平均年資7.1 年。香港機構管理者共六位,有三間是香港老年學會公告獲選為香港安老院舍優質服務全面參與獎機構,三間是持有有效評審認證機構。包含一位男性、五位女性,其在目前機構的服務年資為2~24 年,平均年資9.5 年。本研究結果主要歸納為十項結論,分述如下:一、台港兩地管理者擔任管理者的動機主要受過去學習、職場經驗及個人信念與家庭等三大因素影響,且這些因素彼此之間可能相互影響,其中個因素中各以相似與相異的原因。二、台港兩地管理者在機構扮演角色與工作內容大致相同,其中較為不同之處在於台灣管理者重視人才培育和職涯發展,以及機構內外資源的連結;香港管理者注重市場開發與品牌建立。三、台港兩地管理者在核心職能中,長期照顧職能皆相同,但在高齡者健康老化共通職能、經營管理職能與共同態度方面有所不同,進而本研究依據兩地管理者核心職能結果建立兩地管理者核心職能模型。(一)兩地管理者核心職能在長期照顧專業職能方面的內涵相同,但在高齡者健康老化共通職能、經營管理職能與共同態度方面有些微差異。(二)兩地管理者核心職能模型是由七大共同態度、三大高齡者健康老化共通職能、四大長期照顧專業職能與八大經營管理職能所構成的M 型金字塔。四、台港兩地管理者過去初任管理職在遭遇相似困境中,所採取因應策略皆是透過學習以達個人增能;另兩地管理者在過去所遭遇困境有所差異,因而採取不同因應策略。(一)個人能力不足與工作中不適應為兩地管理者過去初任管理職的共同困境,且所採取因應策略與增能方式會是透過學習,以個人增能為優先。(二)兩地管理者在初任管理職所遭遇的困境有所差異,台灣管理者遭遇人事管理、家屬投訴、機構營運及建立制度與模式等困難;香港管理者則是遭遇第一次參與安老院舍評鑑的困難,因而採取不同的因應策略以克服困難。五、人事管理、機構品質及機構營運與發展為台港兩地管理者現在共同困境,其中在各困境中兩地各有相似與相異之處,但兩地管理者所採取的因應策略則以促進機構整體發展與提升服務品質為主要目標。六、政策變遷與發展被兩地管理者視為機構的未來困境與挑戰,台港兩地管理者對新政策推動所提出因應策略差異之處在於社區連結與否。七、台港兩地管理者過去增能方式皆以正規教育、非正規教育與非正式學習為主,藉以提升個人能力;現在增能方式以非正規教育與非正式學習為主,其中較特別之處是台灣管理者還有參與正規教育,藉以達到個人與機構增能。八、增能結果皆對於台港兩地管理者個人與機構增能產生正向影響,然而台灣管理者比香港管理者重視與社區的連結與社區增能。九、從過去到現在增能中,增能結果也可能影響台港兩地管理者持續擔任管理者與工作動力,甚至會影響個人未來持續學習與增能的方向。(一)在增能歷程中,有團隊支持與認同、住民的改變,以及從工作中找到成就感與自我價值是支持兩地管理者持續工作動力;其中較特別的是台灣管理者還將機構永續發展與傳承作為個人使命與持續工作動力。(二)機構管理與老人照顧相關課程是兩地管理者未來增能的目標,較不同的是台灣管理者想學習團隊增能與人才培育、老人政策與國外長照經驗,及活動帶領課程;香港管理者則是想學習心靈成長類的課程。十、台港兩地管理者增能模式是由六項要素所構成,且每個要素之間會彼此產生連結,並以經驗學習貫穿管理者增能歷程,同時隨著個人職務升遷或改變形成增能模式與循環歷程。LOF第二高的摘要為1.214507,共有1415個字,摘要內容如下:

隨著醫療科技的進步、全球老化及慢性病人口增加,醫護人員面臨生命末期照護的機會升高(蔡、李,2002;胡、張,2015),非安寧單位醫護人員應具備臨終照護、協助病情調適、後續照護及出院規劃等能力,以提供病人及其家人適切之生理、心理、社會與靈性層面之照護。而各單位病人所遇之生命末期照護情境不同,各單位護理師對末期照護的認知、態度亦有所差異,包含症狀控制的概念、心理社會評估、相關倫理思辨等層面,目前於護理養成教育、醫院在職教育在生命末期照護之課程有限,專業學會所開設之課程完善但並非臨床護理人員皆能彈性排假,難使照護不同病人族群之護理師有系統、有效率的學習與其照護病人相關之末期照護技能。盼能以此研究了解照護不同病人族群之護理師於生命末期的教育需求,使不同單位的護理人員能依自己的需求,有效率的學習末期照護課程,提升整體末期照護品質。本研究以橫斷性研究方法,採立意取樣,以臺北某醫學中心內科系病房及腫瘤科病房護理人員為研究對象,共收案380位護理人員。研究工具為自擬半結構式問卷,內容包含護理人員基本資料、工作經驗、生命末期照護學習經驗,以及常見生命末期照護情境之遭遇頻率、執行困難程度、教育需求程度的相關資料,共四部分。研究發現護理人員於生命末期照護情境之教育需求平均得分為3.68 ± 0.56(Lickert scale 5分),介於「普通」至「有需求」之間,以「轉介評估與說明安寧緩和照護」最高(平均得分3.75 ± 0.65),得分高至低依序為「生理層面照護」(平均得分3.74± 0.67)及「心理、社會及靈性層面照護」(平均得分3.74± 0.61)、「倫理、法律、自我覺察」(平均得分3.61± 0.67)、「團隊合作與溝通」(平均得分3.42±0.71);依得分最高之題項排序前5者,為「評估及協助家屬的病情調適情形」、「評估及協助末期病人的病情調適情形」、「評估及協助家屬的情緒困擾」、「評估並處理末期病人的緊急狀況」、「評估及協助末期病人的情緒困擾」。而整體生命末期照護情境之「教育需求程度」與整體之「執行困難程度」呈中度正相關(r=0.60,p<0.01),與整體之「遭遇頻率」呈低度正相關(r=0.12,p=0.02)。生命末期學習經驗的不同,整體生命末期照護情境之「教育需求程度」有顯著差異,另外,於「學歷」、「重要親友往生經驗」、「參與專科學會與否」、「參與安寧緩和護理學會與否」、「參與急重症護理學會與否」、「工作單位」、「護理進階層級」、「曾參與院內其他專科課程」、「曾參與院內線上課程」於各層面之教育需求程度有所差異。「倫理、法律、自我覺察情境執行困難程度越高」、「轉介評估及說明安寧緩和照護之困難程度越高」、「心理、社會、靈性層面照護情境執行困難程度越高」、「年齡越低」、「有參加安寧緩和護理學會者」,為整體生命末期病人照護情境之教育需求中重要的預測因子,可解釋整體變異量達39.14%;其中,「倫理、法律、自我覺察情境執行困難程度」是各層面教育需求之共同預測因子。未來可依據各情境之遭遇頻率、執行困難、教育需求在各單位及各進階層級的分布情形規劃「共通課程」與「具單位特殊性之課程」,使臨床護理人員的學習狀況更貼近其需求;往後的研究建議可以針對「需求內容」及「困難來源」有更深入的討論,進一步針對不同護理角色、不同準備度的護理人員有更精準、細緻的課程規劃,以加強末期照護中護理角色的深度及廣度。4-2. LOW最低的兩份摘要 / The abstracts with lowest and second lowest LOF

接著讓我們來看看LOF分數最低的摘要,該摘要的LOF為1.000391,共有668個字,內容如下:

背景:機構式服務不僅照護時間長,照護內容複雜,照護需求由「治療」轉為「治療與照護並重」,照護品質日益受到重視。台灣醫療照護品質指標系列THIS與台灣臨床成效指標系統TCPI對於醫療品質改善皆有顯著貢獻,並涵蓋長期照護指標,屬全國機構皆可參與的全國性品質指標監測系統。然而全國性的品質指標監測系統在一般護理之家之間尚未普及。目的:1.調查我國一般護理之家採用全國性的品質指標監測系統之現況。2.探討一般護理之家採用全國性的品質指標監測系統的知識障礙為何。3.探討知識障礙如何影響一般護理之家對全國性的品質指標監測系統的採用意願。方法:對全台514家一般護理之家進行問卷調查,共回收125份有效問卷,有效回收率為25%。透過迴歸模型分析各變數對機構採用全國性的品質指標監測系統意願之影響。結果:「財務知識障礙」、「組織知識障礙」及「行為知識障礙」對全國性的品質指標監測採用意願有顯著負向影響,影響依序為「組織知識障礙」、「行為知識障礙」、「財務知識障礙」。表示財務的籌劃、機構內部工作流程的調整與人力規劃,以及人員的心理調適是影響全國性的品質指標監測系統成功導入機構的關鍵因素。結論:本研究結果顯示一般護理之家採用全國性的品質指標監測系統僅為20%,採用現況尚未普及。首先財務知識障礙問題,機構方與醫策會或醫務管理學會需共同訂定符合一般護理之家的收費標準。組織知識障礙問題,由高階主管帶領,組成推動全國性的品質指標監測系統小組,定期開會將工作流程及人力配置整合到最佳。最後,行為知識障礙問題,讓人員認識到需要改變,並進行培訓提高人員的技能。LOF分數第二低的摘要為1.001758,共有696個字,內容如下:

隨著社會變遷與價值觀改變,現代女性必須外出工作,在職場上面對競爭的壓力,同時也背負著傳統女性照顧家庭的職責。女性面對多重角色形成的壓力,對健康造成負面影響,而女性化性別角色特質較強者,壓力也較大,影響健康。本研究主要目的為:(1)探討多重角色女性護理學生角色壓力、身心症狀、性別角色的相關性;(2)探討多重角色女性護理學生性別角色於角色壓力與身心症狀關係的影響。本研究為一橫斷性研究,以方便取樣法收集具有護理師/士職照之在職進修女學生,並兼具職業角色、配偶或/和父母與學生的角色者,共收案219人,以結構式問卷收集參與者性別角色、角色壓力與身心症狀的狀況,研究工具為女性角色壓力量表、身心適應問題量表與性別角色信念量表;女性傳統特質的題平均值與標準差為3.32 ± 1.20,以題平均值作為女性傳統特質的分類,在±1 SD之間歸類為對女性傳統特質沒意見,得分≧ 4.53歸類為認同傳統女性角色,得分≦ 2.12歸為不認同女性傳統角色;運用描述性統計與t-test、變異數分析(ANOVA)、複迴歸分析等推論性統計方式進行資料分析。研究結果為:(1)角色壓力與身心症狀有顯著相關(p < .001);(2)與公婆同住者,身心症狀較少;(3)女性傳統角色的態度不同,角色壓力與身心症狀的關係也不同,對傳統女性角色態度沒意見者,角色壓力與身心症狀呈現顯著正相關,而對傳統女性角色態度不認同或認同者,角色壓力與身心症狀的關係,則未呈現顯著性。本研究結果傳統女性角色態度為沒意見者,角色壓力越大則身心症狀越多。本研究可供在職進修之護理工作場所及護理學校參考,協助在職進修女性護理學生調適多重角色的生活。4-3. LOF高分與低分之間的區別 / The difference between abstracts with high LOF and low LOF

LOW較低的兩份摘要都採用了問卷調查的研究方法,摘要大多內容都在報告研究分析的結果,而大部分問卷調查報告結果的方式則都很相似,因此它們代表著大部分研究摘要的常見寫法,反映在LOF,就是LOF非常接近1。

LOW較高的兩份摘要中,LOW最高的摘要採用了訪談法,除了敘述受訪者的背景之外,該摘要佔一半以上的篇幅都在撰寫該研究的結果。LOW第二高的摘要則採用了問卷調查研究方法,但是該摘要用了三分之一的篇幅講述研究背景,使得他的用詞有更多與其他摘要不同的地方。

有讀者可能會問:「LOF的分數是不是跟字的長度有關係啊?」讓我們拿字數來做皮爾森積差相關分析,結果可以發現兩者的確有顯著中度正相關。以這個例子來說,摘要字數越長,越有可能跟其他摘要使用不同的字。

不過這邊有個例子特別不符合LOF跟字數之間的關係,那就是LOF倒數第9名的摘要。它的LOF為1.004207,可說是相當接近1,但是它的字數為1051,是排行第四多的摘要。讓我們來看看該摘要的內容:

目的:探討使用居家式長期照顧服務對主要照顧者健康之影響及影響因子。方法:本研究屬橫斷性設計,納入2011年1月至2012年4月期間,於臺北市長期照顧管理中心登記且通過審核使用長照十年計畫服務之被照顧者及其主要照顧者。以電話聯繫被照顧者,同意參加者寄發兩份問卷(被照顧者與主要照顧者填寫)及知情同意書,填寫後寄回。結果:研究對象共納入525對主要照顧者與被照顧者。65歲以下的主要照顧者自覺健康狀況影響因子為與被照顧者的關係及曾經使用居家式服務、65歲以上的主要照顧者自覺健康狀況之影響因子為每月花費在照顧長者的費用佔全家總收入比例、被照顧者自覺健康狀況及曾經使用居家式服務。男性主要照顧者自覺健康狀況之影響因子為被照顧者與家人的相處情形、照顧長者時間、被照顧者自覺健康狀況及曾經使用居家式服務;女性主要照顧者自覺健康狀況之影響因子為每月花費在照顧長者的費用佔全家總收入比例。輕度失能者其主要照顧者自覺健康狀況之影響因子為目前有工作,以及每月花費在照顧長者的費用佔全家總收入比例;中度失能者其主要照顧者自覺健康狀況之影響因子為被照顧者的媳婦、被照顧者自覺健康狀況及曾經使用居家式服務。主要照顧者為配偶者其自覺健康狀況之影響因子為被照顧者自覺健康狀況,以及每月花費在照顧長者的費用佔全家總收入比例;主要照顧者為女兒者其自覺健康狀況之影響因子為被照顧者獨居,以及與家中長者關係不太好;主要照顧者為媳婦者其自覺健康狀況之影響因子為家中每月花費在照顧長者的費用佔全家總收入比例及曾經使用居家式服務;主要照顧者為其他關係者其自覺健康狀況之影響因子為被照顧者年齡65-74歲以及曾經使用居家式服務。非獨居被照顧者其主要照顧者自覺健康狀況之影響因子為每月花費在照顧長者的費用佔全家總收入比例與被照顧者自覺健康狀況;獨居被照顧者其主要照顧者自覺健康狀況之影響因子為全家一個月總收入與家中每月花費在照顧長者的費用佔全家總收入比例。結論:根據結果可知1.使用居家式長照服務對主要照顧者年齡≥65歲、男性及主要照顧者為其他關係者其自覺健康狀況有正面影響;對主要照顧者年齡<65歲、被照顧者中度失能、主要照顧者為媳婦者其自覺健康狀況有負面影響。2.主要照顧者家中每月花費在照顧長者的費用佔全家總收入比例、被照顧者與家人相處情形、與家中長者關係、曾經使用居家服務與被照顧者年齡等為影響主要照顧者自覺健康狀況之重要因子。未來制定長期照顧政策及提供服務時可考量主要照顧者健康相關特質,針對不同需求提供相對應服務,以提升主要照顧者健康。仔細看一看這篇摘要,你會發現它用到了大量重複的字詞:「主要照顧者」,而它也採用了常見的問卷調查法,並以常見的問卷調查結果報告的形式來撰寫摘要。這跟前面的LOF較低的兩篇摘要相比,雖然它的字數較多,但寫法是不是看起來很像呢?

由此可知,如果要找出最特別的文本,光看字數可能會不太準。使用LOF來計算文本的異常程度,以此找出LOF最高,也就是最特別、所用字詞與眾不同的文本,可能是更好的作法。

結語 / Wrap up

本篇利用資料探勘中異常偵測的演算法局部異數因素(Local Outlier Factor, LOF),為大量文本計算LOF分數,從中找出用詞最為特別的文本。在大部分統計分析和資料探勘的研究中,異常偵測或離群值偵測大多是用來調整模型、刪除過於怪異的結果。但在文本探勘中,用詞最特別的文本則有其特別的價值。

從本文使用的30篇摘要中,我們可以用較高的LOF來找出最特別的摘要寫法,因此可以藉此找出獨特、與眾不同、別有用心的研究者。另一個可能的應用案例則是學生的報告或是考試的申論題。在同樣的報告題目或申論題題目之下,大部分學生寫的內容應該都大同小異,更可能會有多位學生上網抄襲,還抄到了同一份網頁的內容。這時候使用LOF來找出最為特別的回答,可能也可作為老師在評分上的參考依據來源之一。

即使文本探勘可以採用與傳統資料探勘類似的作法,但它們探勘出來的結果與意義,可能會有很大的不同。這篇使用LOF來做文件的異常值偵測,偵測出來的不是傳統意義中,讓研究者看起來十分礙眼、恨不得趕快刪掉的異常值,而可能是研究者中獨特的瑰寶喔。就讓我們繼續探索文本探勘的無限可能吧。

如果想要更深入瞭解異常偵測的計算方式,我推薦大家可以去閱讀「資料智慧化:利用資料科學,將資訊化為創建」一書。書目如下:

Foreman, J.W.(2017)。資料智慧化 利用資料科學, 將資訊化為創見(胡為君譯)。臺北市:碁峰資訊。

閒聊 / Off-topic

又來到我們的閒聊時間啦!寫到這裡根本就是抒壓活動。

這次寫這篇花了三個半小時,再加上事前準備資料、模擬操作,大概花了六個小時左右。不過字數的部分,怎麼看都不可能只有三千字,畢竟前面的摘要字數就已經接近三千了。好吧,再加一條issue。

不過這次跟前幾次相比,這次的issue增加數量已經很少了。而且這一篇最大的改良,就是加入了記憶體使用量的限制。如果記憶體使用量超過6%,則將暫時停止OCR。一開始我設成50%,結果它在6.8%的時候當機。後來我將限制設為6%,之後寫下來一路順暢,再也沒有當機過了。看來這次確實克服了上一篇因為OCR記憶體耗掉過多的問題,真是可喜可賀。

此外,這篇也開始使用WebSQL來記錄事件,畢竟在Google分析上記錄的事件還要等幾天才能看到結果,實在是讓人心癢難耐啊。

打開之後的結果長這樣子...嗯...看來還有很多需要改進的問題...

我想想,用這個事件記錄可以做什麼東西呢?直覺想到的是字數跟圖片數量的變動,這樣我可以畫個折線圖,看到我從頭到尾的字數和圖片數量的增減。另一種圖是活動的強度,就是以我在同一個時間區段下操作事件的次數來判斷活動的強度。

不過目前這樣的資料,要靠LibreOffice Calc轉換,實在是太麻煩了。我還是加個issue,必須直接算出年、月、日、時、分、秒,這樣比較好分析。而且數值結果也還要重新呈現才行。

一個一個來吧。這篇就來把OCR做完,收個尾吧。

那麼這次使用LOF來找出最特別文本的教學就到這裡了。寫到最後,我有些問題想問問大家:

- 你有處理過含有離群值的資料嗎?

- 你怎麼定義離群值,或是怎麼做異常偵測的呢?

- 你是怎麼處理離群值呢?直接刪掉嗎?

歡迎在下面的留言處跟我們分享你的想法。大家的意見是我繼續分享的動力喔!如果你覺得我這篇教學實用的話,請幫我在AddThis分享工具按讚、將這篇分享到Facebook等社群媒體吧!

感謝你的耐心閱讀,我是布丁,讓我們下一篇見。

![2019-0722-231528-Local-Outlier-Factors-LOF-LOF-LOF.png 異常偵測演算法 4/4﹚ 局部異數因素Local Outlier Factors, LOF LOF分數接妝1 表示普通 LOF分數大於1 表示巽常 LOF 1﹒34 ET [Ke] Soke]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEiRA2pZ5_QtzhPUjJ3E1RzVRSx_TDCa8Sv7thXDejyyMiaYvT-2wgQ3uabep18p6aDSmHsVpMAxKOYwfJSj42-onz1C3n4UA4g8LDWxLNGKDfd2IbTJ6KaN5-4OlrHCnDNPctdnag/s450-rw/2019-0722-231528-Local-Outlier-Factors-LOF-LOF-LOF.png)

![2019-0723-003126-Refresh-repository-cache-uamu-Toggle.png E H二 E K m Refresh repository cache uamu Toggle oad N o i endencisicorficts o m [Pace Meo I m O Loaded 0 0 10 m 104 E 圍- ws i massiveOnlineAnalysis Data streams. 103 metacost E 103 Gf regesean [cer JA localOutlierFactor: Filter implementing the Local Outlier Factor LOF outlier/anomaly A detection algorithm. URL: http://weka.sourceforge.net/doc.packages/localOutlierFactor Author: Mark Hall Maintainer: Weka team wekalist{[at]}list.scms.waikato.ac.nz](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEjuPXPYvxe43fm7CzsrFdeoG5ShAmL8mnSDrI9fR2D81GS2HrR7u7yg8h_7TzGZvPcWYGWNd64QoI8CkhpLBr3J4Dq7eChuKMI-IaSySvPoEf1bUM2j0KDpyJ3Pll-qJnKmsjQDqQ/s450-rw/2019-0723-003126-Refresh-repository-cache-uamu-Toggle.png)

![2019-0723-032739-text-mining-lof-File-Edit-View-Insert.png 因text-mining-lof [ a 代 File Edit View Insert Format Data To Add-ons Help Allch EP Huw 乙00 123v Avial - 10 BISA ﹒ 託E am ﹒吳H銘E來電 代S紙皇曾緒RE 沙括伐絕皋絕紅 芳惠代的2絕Lab SHAEBAREEBR Nh Ra 井﹒明代桂自伐8絕鋸2三﹒放8皋紙追g霖﹒苑商 o o m i li 1代一維細 2 BUARNC BREE MRRERERE EA EES SS o AGERE SUES pi BEAR EARLE METERED Bilas CERREEEBS EERE 0H o KL BC HEIRLEPRRARERE IE ARRRRR EAI FR RRSRTEARTDONG. ARTI, ^ ” 1 abstract url LOF 2 AHRETEN a ps://hdl handle net/11296/4smyT2 3 Bf : ¥-H4d httosihdl handle net/11296/bzi7cd BM 7 d SME AD¥{ httpsi//hdl handle net/11296/7f299% B To 2 EEHMS EHihihsijhdlandenai2Siini 5 HBEEAHW htips//hdL handle net11296/yy4 3x] B tos ind handle net/11296kqéut J : BBE ES https hdl handle net/11296/nz54: Bi 48 71 s Agmggz wgWhausipd﹚asdsom/02onrw﹒W ams tokenization ¥ to 螺Smos](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEhoO3NAwHs-cIa31E2IRa89K1jiP-Padln7-2FQknlh0nGHcspKsAk2SSG7yrWvmDTkXSOFHlqRuMtIrx2VC5y3RUROtBCmmGp-yd4dOcpIIQiPoMCqf5jPTDJlDpltOL4NXYrsEA/s450-rw/2019-0723-032739-text-mining-lof-File-Edit-View-Insert.png)

![2019-0723-010008-Raw-Text-Processed-Text-HD-RE-Gif.png Raw Text 2 a; Processed Text. E 刀S入HD 8 年2 M n o n n E o 唱顏 楊紙5負g領責木珂負希地 o i a B M o M 0 RE 習棍活系紙蛇宏服普華T作沈E人力 皆g Gif TANSERRNE & EE i oohRi i 荊 2 2 ‥ ﹒ ﹒ ˍ Egg i Word Remap User Dictionary Stop Words D earmpe 2] 2]史osumge 0如委史 n. AE 6 0 Oo I](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEhFSOWJR6j_1a-seKQdQFdA8pLUDrIBjQ5r5EgtHkXyuzceFcBgP6eFUTCrdJzUNPE5w1SvBKsyBM4fBCOQkoNSohJb9_4Xvu4CmTWyp38buX4YvRJigXOiuChHvTetl4SdzI2lew/s450-rw/2019-0723-010008-Raw-Text-Processed-Text-HD-RE-Gif.png)

![2019-0723-010600-Raw-Text-Processed-Text-BRE-STE.png Raw Text 2 a; Processed Text 5闌 E g E ] o n n BRE STE ARE SRE Ea FE RAN E o J RE RE ETRE 18 FEAT LOR FIER HS REE AWB EES A RAE] FEIT RE EEA A fh 194 Eg ERE—RER? ROKER ASAE B no 78 mi B M M 00 John / fh 抽標蔣細紙J昜 宏界維工任浪&力PE FAM Hob AES LES #利 3 i M AF BE EA TRE AY Wi E o 0茹堯方式場踊棍台泰需在被絕國福棍唸理 荊 2 HEX AR SR RE AR SARL RAR ﹒ orem ea Jom ___ een ‘Word Remap User Dictionary Stop Words 2 eamge 一一二2 eemge 一一二2 semge 一一二 自 6 0 Oo # Lt .](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEi5g2SQicS5LIbVTdxAXGpKaGi337CgilOX_qTGRlagTQABcA2ilJ8M2JmIiMO4NL5Vw8CqFwFaMAcLbtH0E2dICVawKLnVJrTKxJZ2BFLvcGjQmqGZKn1YSGLg-D0oTwGQBYeQeA/s450-rw/2019-0723-010600-Raw-Text-Processed-Text-BRE-STE.png)

![2019-0723-010924-Copy-of-text-mining-lof-File-Edit.png 因Copy of text-mining-lof a 代 File Edit View Insert Format Data To Add-ons Help 3L2ia EP Huy 乙00 123v Arial 0 BISA尕 HE. BBUEITETANEE EASES FABRA 8 UA AARAYS, ARSRsTNER. 2 : oe 1 abstract url LOF 3 EN hitps//hdl. handle net/11296/yjtoky a Big CM hitps://hdl handle net/11296/tje63: 2 PXEBAHETS https//hdl handle net/11296/37rd! 23 fRPBEF BE hitps//hdl handle net/11296/k69xs] u EHETPWISEE https//hdl handle net/11296/569w]s 25 AHIZEFBHERE https//hdl handle net/11296/7vj58, 25 pb ACIAS#S 2 https://hdl. handle net/11296/hed5 石MEN鮑M hitps//hdlhandle net/11296/7t4hk] 3 EF AER https//hdl. handle net/11296/s49wdh 29 BEE RBA https//hdl handle net/11296/jk499 3 i8 iHiMhipsihdandennz128F2E 31 [78 #48 EA https//hdl handle net/11296/.! CEE EE 一 一一 R data tokenization Yh to 螺Smos](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEji3pQVHZgnXuHB4Lf8qgTMDvnIqaMOQkfEqK90FSj8sI-n1VUbNL-cmmgOlhpvVZzhYEbFOXd7QOnhG49UP44_ms859FDbnPz-D22j4nK1HY3bar1cx2et3Jnjsh3Nv4XHLuTU6w/s450-rw/2019-0723-010924-Copy-of-text-mining-lof-File-Edit.png)

![2019-0723-013014-ER-Explorer-emun-Freprcess-las-Guster.png ER Explorer emun Freprcess las Guster Associate Select amoues [ viuatoe [rorecest] ˍ Coven oven mm smm nso J [ean J [soe m Choose None Apply mmm secede Relation: text-min. Attributes: 1 ‘Name: tokenization Type: No. Instances: 35 ‘Sum of weights: 35 Missin... 0 Distinct: ... Unique: 25 . Attributes. No. Label Count Weight U m s Io aa Hl Ca] Core J men rm Class: 2 All No. Name HLK 顧 — ii imi] I sans Lo gro ee Je](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEh3TwnqskqPgYwe7ZN7le2HHs_L9dxXBgGxOMmdnpDjhKqvJtYTIc-sjJ6FsWp8zjmG3RoNLI5i_m9PxVD612CXZzkSTPXtykqJz8AaE107YStENqk-LR7Nuj_2-z0-Cev0lqFyoA/s450-rw/2019-0723-013014-ER-Explorer-emun-Freprcess-las-Guster.png)

![2019-0723-013405-Weka-Explorer-len-Em-Openfi-Openu.png Weka Explorer len] Em Openfi. Openu.. [ openD.. [ Generat. [ undo Edt. sae. Fiter C D Current relation Selected attribute Relation: text minin. Attributes: 1 Name: tokenization Type: Nomi. Instances: 35 Sum of weights: 35. Missin 0 . Distinct Unique: 25 7. Attributes No. [Label [Count wam m g 10 E 3 gmag in Ar [None imat Pat. — I O引uaabea No. [Name ] HLK 22222 status w g](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEj7VvvoQ1b5AB8r3NkjvGjBulKTnHpBgU5nFfjiXBxrYFz-T6lCW3r-2AbGvl_EZt2oo2WOtak8Hjo8xJk77n2IYc7JHtHf3ivmyR71LqA0zuc7qRZgfIdyxh6mO-5vhqKYQhAgrA/s450-rw/2019-0723-013405-Weka-Explorer-len-Em-Openfi-Openu.png)

![2019-0723-013612-open-openu-openD-Generar-undo-Eat.png H一 open. openu.. [ openD... [ Generar. [undo Eat. save. iter 15F ˍ m 口uasmaoi g [7] MathExpression elected attribute 5 ergetscuenttorinanaues ume trent — N gan﹒0 Distinct .. Unique: 25 7... 一usggwmaus 七ini N lass: tokenization Nom . v [ visualize Al 5 NumencToginary 口iumwaqaiempa [5 NumenicTranstorm開伐 [ optuscate IN llclrllllllllllllllll1d [5 parttoneatiteited [5 propiscretze s H ga [5 RandomProjection Log x0 5 Rondomsunast d [5 Remove耳 LEUm Bemesmur 20as](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEiIKnsSAk1wMZR-VUhXpPJRVqloMGWcVDZ-NKC-jkg0qVCvJBaVIpgoM6cHnx9WItPH5vy55nQxFrIqI44gn_r1oaFm9eEtEY2tVBQ6CxEwTSTRAGOPH384J1VjMFq97hZVomx8Kw/s450-rw/2019-0723-013612-open-openu-openD-Generar-undo-Eat.png)

![2019-0723-013704-Weka-Explorer-le-ED-Openfi-Openu.png Weka Explorer le] ED o m Openfi. Openu.. [ openD.. [ Generat. [ undo Edt. sae. Fiter LSmmm wmwwemawscwm Cz Current relation Selected attribute Appl Relation: text minin. Attributes: 1 Name: tokenization Type: Nomi. Instances: 35 Sum of weights: 35. Missin 0 . Distinct Unique: 25 7. Attributes No. [Label [Count Weight m g 10 E 3 gmag in Ar [None imat Pat. — I O引waabea No. Name HLK 22222 status w Ep](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEiy4l5BiMKsj9gY8jJPVUb0EOVvswWh4_76D7LfhiUyGtDuys6YDwY7X8FAe_QFRzFk839koiCfYsdihwjqNFZDlFvX6oWuDfYcmazjxZyAupa0FTxU4HERvAotBpq77XWdnz7Xiw/s450-rw/2019-0723-013704-Weka-Explorer-le-ED-Openfi-Openu.png)

![2019-0723-013839-Weka-Explorer-EE-com-amo-Lsmm-mmw.png Weka Explorer EE com m [amo Lsmm ] mmw cos Fitter oas mwwumsgmm cusa m mmussuw J Saaecuwsmm Ammmer —— ust a ma po s mL mmj[ em國 E tokenization str v visualize Al No Jame ee srt eri muy o grr](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEhEFygMsnh86F9pAZBcNnNGeqnFWM6uUUETaqjemtQyGiiIyoH8LwEpeJ_HNGi9WEHca4VyrpKFA0Bov2UlRpMEzNvkcIL8qoh8PopksoCEINk15ABXk-didC6exemO9KhXDcHcOw/s450-rw/2019-0723-013839-Weka-Explorer-EE-com-amo-Lsmm-mmw.png)

![2019-0723-014351-on-er-mo-RandomSubset-elected-attribute.png on 一一一一一一 一一 er 回I 7 mo d [5 RandomSubset elected attribute 囝Remove ‘Name: tokenization Type: String [ RemoveByName Missin... 0 .. Distinct . Unique: 25 7... [El RemoveType [5 RemoveUseless 口naamemuw [5 RenameNominalValues Rear basses veunzen [Cl ReplaceMissingvalues [Cl ReplaceMissingWithUserConstd [5 ReplaceWihMissingValue bi i shar amet or oval [5 SortLabels [Standardize ] C ” Log x0 一Tmesmapas卜M 口rmeswwsmwsis k Filter... ‘Remove filter Close](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEixge657-9gqVNdaaw_wbz1D864f0AwP7qYhV9q_Ywk3bBW7_F4ecVCKFaR2qMeY4gmy40D-K2XkPImDFn5ts7Pn0yt2GJZjLMpnO7NbSLYDY4X4YtsBPuCl4feaLoi1S9VUEcnhw/s450-rw/2019-0723-014351-on-er-mo-RandomSubset-elected-attribute.png)

![2019-0723-014539-Weka-Explorer-mw-mm-mmo-smm-uwmg.png Weka Explorer H二 mw mm0 mmo smm [ uwmg ][ e mmw w So託oemewweaee刊99uas9﹚uuomoeawa0﹒a0aummaewaevd[ smy Emr Saunwaubas Relation: text-minin. Attributes: 1 ‘Name: tokenization Type: String Instances: 35 ‘Sum of weights: 35 Missin... 0 . Distinct: Unique: 25 7. ampas s xmw][ mm sm E tokenization str v visualize Al No [name ] H MS ae mt i suus o Lo gro](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEi0LQcsI8bKRETvCFkvDrgcVXXUrGhC249H52hGbhwL1Q52nq2J9xfLir8jl0i7DFYvf3Hd2CPtuHcTYjJMAMwqYPQXMohtVipM2U5WMG9e4Di-TnUrW-yzcqbdkGcDIK2NTHGI5g/s450-rw/2019-0723-014539-Weka-Explorer-mw-mm-mmo-smm-uwmg.png)

![2019-0723-014619-saasaemwxoMwae-waailanumunmnsiaphusSmrgiamnaax.png saasaemwxoMwae ˍ w waailanumunmnsiaphusSmrgiamnaax 緝 mmgsmwsmmusuessawsammusemesuubem mw ‘occurrence depending on the tokenizer information from the text contained in the strings. Capabilities ot fae ˍ一一一司 won am ˍ一一一進 attributelndices first-last i下 s mg ˍ一呂 diconanfileToSaveTo same ˍ mmesssss 9下 apenas fe ˍ一一一筵 wasn rae ˍ一一一司 Ommeamass Emg一一一司 i nio n 000 ee ˍ切 emmmemeoms sae ˍ一一一一司 periodicPruning -1.0 sudo fe ˍ一一一刈 BE ˍ we” ˍ toner ouuus lmwwrwemew asian vor Com J me Jo Bows]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEj1j0nSmoNogzhCA_tnhnzs2pA2V4nOuD4xebKntzAIBO24kmvx4QIYgrj3oGqox2lpnyfkatQMEzWIDh53ejRd3xwj-GhThnrm2ZfYN3wzn9oujjBnYzxxccTkU-PQAVaXIR5YRg/s450-rw/2019-0723-014619-saasaemwxoMwae-waailanumunmnsiaphusSmrgiamnaax.png)

![2019-0723-015100-wea-oir-cn-oven-ven-coven-ene-noo.png wea oir 】 cn. oven] [ven ] [coven] ene noo [ot] [sre gr Ghose smwnmeawsnswwwuaowimumuamoeaga0a0ammmw[ ] mm awaubss Relation: text- Name: 00 Type: Num. Instances: 30 Sul Missing: 0 . Distinct: .. Unique: 1 3% press oe jaw ini 9 mn : Con Com Coen Cr { i Sees繁 a n 9 Class: & Num Visualize All z口mm 30] 002 4 00s a 5凹m soa 4 Q ! 2 sans o Log gg x0](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEjf55OUJsBuMDbJUA5Uf9XOIpP55ZT3jfz7OQ1iVDFICJHx6-pRHzP1U_3Frhy_DlQqJC812DfhRTIKLpF-Dh7KdNISnfFjn7sknW__3d2GqqXSBMhF5zA9LiC-4OxYFy-df2ryNA/s450-rw/2019-0723-015100-wea-oir-cn-oven-ven-coven-ene-noo.png)

![2019-0723-015547-jms-mere-ore-CartesianProduct-ected.png [ ] jms 一 一一一 一一 g ˍ 一100 mere 1.10 ore a d [7] CartesianProduct ected attribute [E Center [5] ChangeDateFormat June Type: Num... 因ClassAssigner sing: 0 .. Distinct .. Unique: 0 0% [Er smme ˍ mu ˍ Eom陽【 ˍ戈 白pgewgs 口aomw 5 FoedbiconanstingTonoravec jes u ˍ切uaaueA [7] InterquartileRange [ atnExpression [5] Mergelnfiequentilominalvalues 72 — s因‘MergeManyValues [5 MergeTwovalues — 0 m - Co lemmatosmey](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEgNSDEk5YCnOFx-oudMNrzmN7rTw_iwqMr4ATD016ArtRPg-VSfGPo4BJ0e6a-0U6m5IRmc-QePAn_NvoLVeeYF50vCr8JL8oMR5IZDufxrLXNpGobmzzzIMdCGRG87YiCkNe4efA/s450-rw/2019-0723-015547-jms-mere-ore-CartesianProduct-ected.png)

![2019-0723-015823-jm-um-cm-oom-pr-Gimme-or-in-sor.png jm 一一一J um J[ cm J{oom pr [Gimme or in 1m 0 sor corsa an ﹒ tomer cass J’ Relation: text-... Attributes: 2013 Name: EE Type: Num... Instances: 30 ‘Sum of weights: 30 Missing: 0 .. Distinct: .. Unique: 0 0% me Ee Eee, 3B [No [Name U2msgmmm i corsa 2008 [ 2009 [] #8 a 同中 一一 lo 0 2 一 一一一 wr [ ]](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEg32TMqp0XG0PD7oysvEcPEs4vtlPvfHEea6fwcF_tRzV0XUVz6C48RzkpibPsWbOlzCKD-YBS3Fb8T51zFsqhGNJYgXUpQcighPVW4sqpkU1Jj8qH-TTg_nayiwJlSgVC2mS93YQ/s450-rw/2019-0723-015823-jm-um-cm-oom-pr-Gimme-or-in-sor.png)

![2019-0723-020734-Explorer-Li-opmw-open-open-Gener.png K Explorer Li opmw open. open. Gener. [ undo Eat. sae. Filter Choose LOF -min 10 -max 40 -4 weka.core neighboursearch LinearNSearch - Vwe _Apply Current relation Selected attribute Relation: text- Atributes: 2014 Name: LOF Type: Num. Instances: 30 Sum of weights: 30 Missing: 0 Distinct Unique: 30 1 Attributes E [ value Minimum 1 Maximum 1245 c A None invert [ Pat. T lamstormam Visualize All N d 2013 J 72 I x 1 Remove selected attributes 1.12 128 status w vr] go](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEjnDgLAy0gShvlpXhrBEApOpXB6eukYDhWDXUKKc19UR1knRVN97JeSCxOcvADpWR23aRzFm46BBu1L6x1IbGrrv0_Rhm9yJaruHG_qosxHh1QrZWw7YwH-HfYmVJ_LnmG3nmyJHA/s450-rw/2019-0723-020734-Explorer-Li-opmw-open-open-Gener.png)

![2019-0723-021040-Explorer-LL-kn-Choose-LOF-min-max.png K Explorer LL 一一一一一一 kn闌 Choose LOF -min 10 -max 40 -A weka.core.neighboursearch LinearNNSearch -A Uwe Apply R一 Relation: text-mini. Attributes: 1 Name: LOF Type: Num. Instances: 30 ‘Sum of weights: 30 Missing: 0 Distinct: .. Unique: 30 1. oe me 【 ﹒ ﹝ 心 li d ] Class: LOF Num Visualize All 6 0 日3 -](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEguKBamnZRqpTlroPdZtP6j0it6gumxkqyFG5xmoQTzrB0W_k6L3cBzXgzxgx6aZli8UEcT8yNtBeQ8Vgos1Xeoe7ChM1mdhRoUMHigluZeiLr7INkD-ltcVpaXGjW8LZ5s-2IEwg/s450-rw/2019-0723-021040-Explorer-LL-kn-Choose-LOF-min-max.png)

![2019-0723-021700-Aev-ubwoWeecuc-bosu-brs-Liberation.png 國02Aev ubwoWeecuc bosu brs 同”回‧咳哉‧ Liberation Sans File ¥ t mt B了 jaaa [Xt ax 圜 oom bone Zl 1005925 pa anv TH 1.003648] 瀾lugj Postespecil.. CulShitteV 逸10Q3GS r Shift W 副1巳maal ﹒mwesme LIT en sis 遁10X8L Select C umn Ctrl Space S Oo WAP NH Find... cmur 工口fmimmmaws ak i Find mmmiai 5am 9 MM Add LE](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEikpinWpYDuBqndkVrlZHv4BniK3H9fEtlBuAVhjR6OKCnehUwuTXvLnlsAUvwg9YOrsK0iEEPC01gCB-oV0uQtgAM8gmuEARa4dfrIXv77CNfr2O692Pk8v7QJEq04JfAlYGsVag/s390-rw/2019-0723-021700-Aev-ubwoWeecuc-bosu-brs-Liberation.png)

![2019-0723-024609-text-mining-lof-result-File-Edit.png text-mining-lof result 崇a 忍 File Edit View Insert Format Data To Add-ons Help Allch s 八蕙笑D9N 乙妾Ga A 8 ig BISA ‥ 託E am ﹒吳H銘E來電 代S紙皇曾緒RE 沙括伐絕皋絕紅 芳惠代的2絕Lab SHAEBAREEBR Nh Ra 井﹒明代桂自伐8絕鋸2三﹒放8皋紙追g霖﹒苑商 o o m i li 1代一維細 2 BUARNC BREE MRRERERE EA EES SS o AGERE SUES pi BEAR EARLE METERED Bilas CERREEEBS EERE 0H o KL 託81 EN « Heh ABBBERS I] 5 ANSEF EABSORR AREREH ” B url LOF length 2 4代哉4 https. agliamds 1.245387 1792 3 BEEBE htos/hdL handle 1.214507 1415 4目8 垂hpgihglhxdh 1.201257 1215 M g人E hpginlhaxs 1.168463 914 5 tR4REA W https //hdl handle 1.139352 747 gx SHEgdhlhwgg 1.138757 6 ﹢ HiREM : Kati https hdl handle 1.124158 859, o WiZHAR ¥i#- httosihdLhandle 1.122567 970 10 RERPEHESE? hitos hdl handle 1.108093 689 1 AWE ELEHES hts //hdl handle 1.10616 667 M i hdl handle 1.097091 824 data 螺Smos](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEgyxeK1l5HDzhaz5XkNHz6LAJFkhfOAqPWybpUsn8zQadrpsf3Z7otFLPmyellB9tbm1UnOP7xiwZl3z_42VkITTEizJ-gOOd6k8Hfnf5CkxeFtjnKvpahBt0Ea94aEUcSX_HQAGw/s450-rw/2019-0723-024609-text-mining-lof-result-File-Edit.png)

![2019-0723-030336-ARS-ELS-EERE-AE-ER-HRIERE.png ARS ] 1 0 口伐尾g倉0.001 洸E歐0.326 ELS 30 EERE AE A0.00165 ER HRIERE](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEiYC4BFCI0N42EX4qzaEkbVzRz0k10ctybld-dkRuHzwtzLWgKIXTOeyWbura2gL-d_ZV9hcyJ9ila-EqT4gHqEH6ELwkHJn0jZ1L87c30p_ZI4DWPKfQGHc9P2_-JtfzErFpVzSw/s282-rw/2019-0723-030336-ARS-ELS-EERE-AE-ER-HRIERE.png)

![2019-0723-030758-abstract-OF-length-Wihiigfhhgihlhxdh.png abstract下u下1OF length 訛#2Wihiigfhhgihlhxdh 1.009587 314 U C 1.007696 314 E R /ihdl handle 1.006287 340 ABZEBLERE hitos:/indl handle 1.005925 442 B69 Brett] htos ind handle 1.004207 1081 由R人M # https /ihdl handle 1.003648 405, EHTS hitos hdl handle 1.003483 551 PTE BEA https /ind handle 1.003218 360 E https /ind handle 1.003205 s VESTS: hitos hdl handle 1.002027 782 WiZAREAN hitos hdl handle 1.001963 BE BE EERE https /ihd handle 1.001758 E 沙 M pgjndhaudk 1.000391 sg](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEhSzbe-VD6VTbW-oMqOnUjyEx0JcK11-EimRjYcHpISLMV0aGBZ85kG1mD_lTBzxDx9oC4sDZOfMVaW-g5KPoaSuz-z8HrfsVCJPThOMBZCKkMXJfYXTjcThCURSVO39GM8qp_sVA/s406-rw/2019-0723-030758-abstract-OF-length-Wihiigfhhgihlhxdh.png)

![2019-07-23_020516-ost-EE-Elements-Network-Cons-Audits.png ost EE [R Elements Network Cons e Audits Sources Performance Memory Application Security NetBeans 1849 i 9 App 回 sp v Fiter K PS 3UImesan progress gstatus: initializing api”, progress: 0} Tesseractrelper. jsios 314userm. Cannot enlarge memory arrays. Either 1 compile with -s TOTAL MEMORY X tesseract-core.wasm.js:8 Nor. with X higher than the current value 263435456, 2 compile with -s ALLOW MEMORY GROWTH-1 which allows increasing the size at runtime, or 3 if you went malloc to return NULL 2 instead of this A Owamings 2bort, compile with -s ABORTING_WALLOC G iugme A Cannot enlarge memory arrays. Either 1 compile with -s TOTAL MEMORY-X fesseract-core wpsm.is: with X higher than the current value 268435456, 2 compile with -s ALLOW WEWORY GROMTH 1 which & GOverbose allows increasing the size at runtime, or 3 if you want malloc to return NULL 8 instead of this abort, compile with -s ABORTING MALLOC Uncaugnt in promise abort Cannot enlarge memory arrays. blob:http://localhos.ach-d207926654ca:1 Either 1 compile with -s TOTAL MEMORY X with X higher than the current value 268435436, 2 compile with -s ALLOW MEMORY GROWTH 1 which allows increasing the size at runtime, or 3 if you want malloc to return MULL 8 instead of this abort, compile with -s ABORTING_MALLOC 6 . Build with 1 btisticingicator.jsiles Jit o Debugging connection was closed. Reason: Render process gone... ci. i. 4 [ Reconnect when ready by reopening DevTo s. Tesseracttelper.js:184 oR is Tesseractielper. juss RCN [Reconnect DevTo Tesseractielper. jsilsa oR is Tesseractielper. juss 4 [RECT m on 2 27 E mm m Z OIE Tesseracttielper. jsi1s4 4 [memory usea”, 149855970, 2197815295, 0.06818405999482133] Tesseractelper. sis progress {status: Loaging tesseract core”, progress: 0} Tesseractielper. jsios 4 [memory usea”, 149867352, 2197815296, 0.06818924332393035] Tesseractelper. sis progress status: Loaging tesseract core”, progress: 1} E 4 [memory used”, 149867362, 2197815296, 0.06818924332393035] E progress {status: initializing tesseract”, progress: 0} Tesseractrelper. jsios 4 [memory usea”, 149889850, 2197815295, 0.06819947530295162] E progress {status: initialized tesseract”, progress: 1} Tesseracticlper. jsi08 4 [memory usea”, 149889850, 2197815295, 0.06819947530295162] E progress {status: Loading Language traineddata”, progress: 0} Tesseractielper. jsios](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEgH5dyzQa0TjEPcXOpE5Kqf7ZBCRecAscSQIHK3M68cbEoETY9OXgpnuQBTad6cgCzMWdt3HuO8XcDYlL87lcDuNkcvs4e17Fc2pO40YpdfTwiJrXXr8N56knM6ueIQ5__9G5ouuQ/s450-rw/2019-07-23_020516-ost-EE-Elements-Network-Cons-Audits.png)